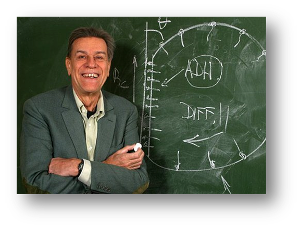

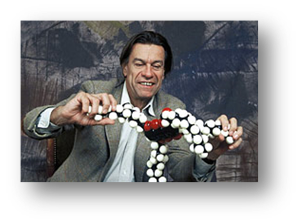

50 ans de recherche et de découvertes en Sciences Physiques par Pierre-Gilles de Gennes Physicien français et Prix Nobel de Physique en 1991. Décédé en mai 2007, il fut le Directeur de l'Ecole Supérieure de Physique et Chimie de Paris et Professeur au Collège de France. |

Il y a eu une explosion en physique et nous en sommes tous conscients. Dans l'histoire de la peinture italienne, il y a un instant précieux (qui pour moi est à peu près le temps de Giovanni Bellini) où, tout à coup, les techniques sont au point et les découvertes jaillissent, les gens construisent et n'ont pas encore le temps de se perdre. Nous avons eu, dans ce siècle, en physique, quelque chose qui est de cette nature avec tout le foisonnement que cela implique. La grande explosion s'est faite entre 1890 et 1950, plutôt avant le cinquantenaire que nous fêtons.

Nous parlons ici de la période immédiatement ultérieure et c'est une très belle période. Comme en peinture, il y a de vastes fresques, et il y a des petits portraits diaphanes, et moi je ne vous parlerai que de quelques petits portraits diaphanes. Sous quelle forme ? Vous devinez mon embarras.

En physique, tout tourne autour de trois choses : des objets, des outils, des concepts. Je vais commencer par parler de trois outils dont je ne prétends pas du tout qu'ils sont les plus importants ou les plus extraordinaires, mais qui me paraissent de bons exemples, exactement comme si je choisissais trois tableaux aux «Offices» de Florence.

En physique, tout tourne autour de trois choses : des objets, des outils, des concepts. Je vais commencer par parler de trois outils dont je ne prétends pas du tout qu'ils sont les plus importants ou les plus extraordinaires, mais qui me paraissent de bons exemples, exactement comme si je choisissais trois tableaux aux «Offices» de Florence.

Le premier, c'est cette idée extraordinaire du transistor, tellement simple, dans son principe. On a une superposition d'une couche de silicium, d'un oxyde (en pratique de la silice) et d'un métal déposé par-dessus : les charges placées dans le métal peuvent contrôler le nombre de porteurs donc, finalement, contrôler un courant. Et ces structures MOSFET à potentiel bas, à énergie basse, ont (du fait qu'elles étaient miniaturisables) bouleversé notre monde. Ce qui est également extraordinaire c'est le fait (peu prévu à l'époque des grands pionniers) que l'on peut miniaturiser de plus en plus, d'abord à l'échelle optique (c'est-à-dire à l'échelle du micron) puis, de nos jours, par des canons à électrons ou par des dispositifs à rayons X, gagner encore une décade, stocker des informations sur des objets minuscules, qui sont de quelques centaines d'atomes en dimension linéaire. Enfin, dans la découverte du transistor le raisonnement a entièrement précédé l'objet et ceci est un exemple très utile dans la défense que nous menons pour la recherche scientifique.

Un autre cas où le raisonnement a précédé l'outil est celui du laser. Mais l'histoire du laser est curieuse. Quand on a un système atomique à deux niveaux, s'il est placé dans le niveau du bas une radiation peut le faire transiter : c'est un mécanisme d'absorption. Au contraire, si on a eu l'intelligence, en général via d'autres niveaux, de placer ce système dans son niveau excité, alors là une radiation pourra le faire retomber ; donc ce système intelligemment préparé sera un amplificateur naturel de lumière et même un oscillateur. Cette idée extraordinaire est venue d'abord dans le domaine des micro-ondes avec C. Townes plutôt que de l'optique et puis, elle est parvenue à la lumière visible, par une série de réalisations différentes (j'ai renoncé à mettre des noms). Une science totalement imprévue émerge dans les années qui suivent. Du fait même qu'on a des faisceaux cohérents et de grande amplitude, on a la possibilité d'une optique complètement nouvelle, où les phénomènes non linéaires deviennent importants ; on entre de la lumière rouge et on ressort de la lumière bleue : on peut propager des impulsions très courtes, parce qu'on peut s'arranger pour les bloquer par des mécanismes non linéaires. Mais il est curieux de noter que les principes du laser étaient présents en un certain sens, dès la première génération, dès Einstein. Et on peut se demander pourquoi le laser n'est apparu qu'en 1960 et non pas dans les années trente. Le résultat net est là, nous avons cet outil qui est un des symboles de notre époque : pour vous montrer les transparents de la conférence, j'en ai tenu un à la main

Un troisième outil (que j'aime beaucoup) est beaucoup plus récent : il nous vient de Zurich ; c'est le microscope à effet tunnel. Il y a une longue histoire dans la microscopie avec un trésor d'inventions optiques, puis un trésor d'inventions électroniques et puis, tout à coup, Binnig et Rohrer lancent un objet totalement nouveau : une petite pointe de tungstène exposée contre une surface conductrice. Il passe entre la pointe et la surface un petit «courant tunnel» qui est d'origine  quantique. Ce courant tunnel est suffisamment localisé spatialement, pour arriver à voir un objet tout petit comme une molécule, en fait, dans la version courante un microscope tunnel a une résolution «horizontale» de 6 angstrôms et une résolution « verticale » meilleure que 0,5 angstrôm. On arrive ainsi à voir des atomes avec un dispositif d'une extraordinaire simplicité. Et, ce qui est peut-être encore plus important c'est le fait qu'on arrive à les voir dans les conditions que l'on choisit, Toute la microscopie électronique ne pouvait s'effectuer que sous un vide considérable, les faisceaux d'électrons étant tout de suite très perturbés par la présence de gaz ou de vapeur d'eau. Ici, pour la première fois, nous avons un outil qui nous permet de voir une molécule individuelle et qui nous permet de la voir en présence de n'importe quel liquide et en particulier en présence d'eau. Tout un énorme secteur biologique et physico-chimique qui était jusqu'à présent inaccessible nous est apporté. Le microscope tunnel est vraiment un outil extraordinaire de notre temps, l'outil sur lequel nos jeunes étudiants vont faire de grandes découvertes. Pour prendre des exemples biologiques, qu'il s'agisse de mitochondries ou de chloroplastes, toutes ces petites usines, on va pouvoir maintenant les regarder hangar par hangar, en positionnant les hangars. Au début, j'étais tourmenté du fait que, dans un microscope tunnel, il faut en principe, une plate-forme conductrice, ce qu'on ne met pas très facilement sous une mitochondrie ou un chloroplaste pour aller le regarder, mais dans la deuxième version inventée par Binnig, on n'a plus besoin de la plate-forme conductrice. Toute la technique consiste à mesurer non des courants, mais les forces minimes qui existent dans cette pointe très localisée et la surface. Par la mesure des forces (sans utiliser de courant donc sans utiliser de base conductrice) on peut là aussi caractériser des objets extraordinairement petits.

quantique. Ce courant tunnel est suffisamment localisé spatialement, pour arriver à voir un objet tout petit comme une molécule, en fait, dans la version courante un microscope tunnel a une résolution «horizontale» de 6 angstrôms et une résolution « verticale » meilleure que 0,5 angstrôm. On arrive ainsi à voir des atomes avec un dispositif d'une extraordinaire simplicité. Et, ce qui est peut-être encore plus important c'est le fait qu'on arrive à les voir dans les conditions que l'on choisit, Toute la microscopie électronique ne pouvait s'effectuer que sous un vide considérable, les faisceaux d'électrons étant tout de suite très perturbés par la présence de gaz ou de vapeur d'eau. Ici, pour la première fois, nous avons un outil qui nous permet de voir une molécule individuelle et qui nous permet de la voir en présence de n'importe quel liquide et en particulier en présence d'eau. Tout un énorme secteur biologique et physico-chimique qui était jusqu'à présent inaccessible nous est apporté. Le microscope tunnel est vraiment un outil extraordinaire de notre temps, l'outil sur lequel nos jeunes étudiants vont faire de grandes découvertes. Pour prendre des exemples biologiques, qu'il s'agisse de mitochondries ou de chloroplastes, toutes ces petites usines, on va pouvoir maintenant les regarder hangar par hangar, en positionnant les hangars. Au début, j'étais tourmenté du fait que, dans un microscope tunnel, il faut en principe, une plate-forme conductrice, ce qu'on ne met pas très facilement sous une mitochondrie ou un chloroplaste pour aller le regarder, mais dans la deuxième version inventée par Binnig, on n'a plus besoin de la plate-forme conductrice. Toute la technique consiste à mesurer non des courants, mais les forces minimes qui existent dans cette pointe très localisée et la surface. Par la mesure des forces (sans utiliser de courant donc sans utiliser de base conductrice) on peut là aussi caractériser des objets extraordinairement petits.

Voilà trois outils (on aurait pu penser à bien d'autres !) mais je pense que ces trois outils-là sont typiques de la période 48-88 que nous évoquons aujourd'hui.

Après les trois outils, j'ai envie de vous parler de quatre «objets naturels». Le premier est la nébuleuse du crabe qu'ont commencé à voir les astronomes chinois autour de l'an mille. Un endroit initialement totalement tranquille du ciel, et tout à coup, une énorme explosion se fait et au cours des années, elle prend ces dimensions fabuleuses : nous l'appelons Supernova. Et quelque part au centre, nous savons maintenant qu'il y a un objet qui subsiste. Beaucoup d'entre vous savent de quoi il s'agit : on prend une étoile à peu près grosse comme le soleil, on la prend vieille, ce n'est pas difficile, on la prend dans une situation où elle se refroidit, où elle a tendance à s'effondrer sur elle-même. Quand elle réalise cet effondrement, très souvent, elle trouve bénéficiaire de réaliser la réaction « bêta inverse » où un proton et un électron se recombinent pour former un neutron. Et ce qu'elle gagne à ce fait, est qu'elle élimine ces électrons qui étaient des particules très légères ; la mécanique quantique nous dit qu'une particule légère se délocalise beaucoup, a beaucoup d'énergie cinétique. On évacue ce problème par la réaction bêta inverse et on passe d'une matière qui était essentiellement formée de protons et d'électrons à une matière formée de neutrons, on engendre au centre de la nébuleuse une étoile de neutrons, imaginée par Oppenheimer et Voltoff en 1939, juste au début de notre période de 50 ans. Les méthodes de l'astronomie, méthodes modernes, ont permis de prouver l'existence des étoiles de neutrons, notamment avec des fusées qui pouvaient porter des détecteurs X et former une cartographie X du ciel. J'enseignais à cette époque, dans un DEA, une sorte de panorama des fermions. J'y parlais des naines blanches (gaz d'électrons) et des étoiles de neutrons - en disant qu'elles devaient exister mais que personne ne les avait vues. Quel bonheur quand on les a trouvées ! Encore après des années, je reste stupéfait devant cet objet.

Voici ensuite la 2ème étape : une jeune femme Jocelyn Bell, en 1967, s'aperçoit qu'il y a des signaux émis dans le ciel avec une fréquence de l'ordre d'une fraction de seconde et d'une régularité totale et progressivement la communauté réalise que ces signaux proviennent d'une petite étoile de neutrons, qui tourne, et qui porte un énorme champ magnétique : ce champ magnétique rayonne, émet comme un phare et nous mesurons ainsi la période de rotation de l'étoile (quelque chose comme trente tours/seconde). Donc un objet totalement extérieur à notre expérience, une étoile de 10 km de rayon, mais qui a la masse du soleil, une étoile qui est fluide qui a à peu près la consistance de l'intérieur des noyaux, mais qui a une petite croûte solide sur l'extérieur, quelques millimètres de croûte solide ; et cette croûte solide a d'ailleurs tous les ennuis, exactement comme la nôtre sur la terre : les tremblements de terre de cette croûte sont suffisants pour perturber de façon visible les périodes d'émission. Les étoiles de neutrons sont des objets naturels extraordinaires, identifiés grâce à un concours admirable de méthodes de détection et de raisonnement.

Voici ensuite la 2ème étape : une jeune femme Jocelyn Bell, en 1967, s'aperçoit qu'il y a des signaux émis dans le ciel avec une fréquence de l'ordre d'une fraction de seconde et d'une régularité totale et progressivement la communauté réalise que ces signaux proviennent d'une petite étoile de neutrons, qui tourne, et qui porte un énorme champ magnétique : ce champ magnétique rayonne, émet comme un phare et nous mesurons ainsi la période de rotation de l'étoile (quelque chose comme trente tours/seconde). Donc un objet totalement extérieur à notre expérience, une étoile de 10 km de rayon, mais qui a la masse du soleil, une étoile qui est fluide qui a à peu près la consistance de l'intérieur des noyaux, mais qui a une petite croûte solide sur l'extérieur, quelques millimètres de croûte solide ; et cette croûte solide a d'ailleurs tous les ennuis, exactement comme la nôtre sur la terre : les tremblements de terre de cette croûte sont suffisants pour perturber de façon visible les périodes d'émission. Les étoiles de neutrons sont des objets naturels extraordinaires, identifiés grâce à un concours admirable de méthodes de détection et de raisonnement.

Voilà maintenant une autre famille d'objets naturels (que j'aime beaucoup) : les superfluides. Les fluides qui nous entourent sont des fluides visqueux, dissipatifs, mais certains fluides sont anormaux et peuvent être totalement sans viscosité, c'est le cas de l'hélium 4 dont la superfluidité a été découverte par Kapitza, au début du cinquantenaire dont nous parlons. Sous sa forme la plus épurée, l'expérience consiste à lancer de l'hélium liquide dans un anneau à une température suffisamment basse et à observer que cet hélium continue à tourner indéfiniment. Cette superfluidité dans un anneau, avait été observée depuis le début du siècle dans certains métaux dits supraconducteurs. Dans ce dernier cas, il ne s'agit plus d'un liquide usuel mais d'un fluide d'électrons qui coule à l'intérieur d'un métal. Au début des expériences sur la circulation de courant électrique dans le mercure, on voyait un courant tenir un an ; de nos jours, grâce au raffinement des techniques de résonance nucléaire, on sait mesurer le champ magnétique produit par le courant avec une précision extraordinaire ; on sait voir la dérive éventuelle du champ et l'on sait dire que dans un anneau typique, le courant paraît stable pour des millions d'années. Depuis, on a trouvé bien d'autres superfluides : d'une part les noyaux atomiques nous montrent un phénomène de superfluidité dans la façon dont ils tournent. On distingue un oeuf dur d'un oeuf pas dur par la façon dont il tourne ; eh bien, d'une façon un peu analogue on distingue un noyau superfluide d'un noyau normal par la façon dont il tourne. Et la matière des étoiles de neutrons, dont nous parlions tout à l'heure, est encore un exemple de superfluide. Bien entendu, cette présence de la superfluidité dans des systèmes aussi variés, a provoque une réflexion énorme, et cette réflexion d'ailleurs est une très bonne leçon d'humilité pour nous, théoriciens. Parce que l'on voit de très grands noms qui ont été pas tout à fait capables de Ia mener jusqu'au bout. Par exemple, un des physiciens pour lequel j'ai personnellement le plus d'admiration, Lev Landau, a décrit les lois de la superfluidité dans l'hélium avec un luxe de détails extraordinaire, mais, en même temps, si on lit soigneusement ce qu'il a écrit on voit qu'il n'a pas tout à fait compris l'origine du phénomène. L'homme qui a vraiment compris la superfluidité est Fritz Londoii qui a pensé à lier cette propriété à un effet de statistique. Celà vaut peut-être la peine de passer une minute là-dessus. Habituellement, pourquoi est-ce que nous avons de la dissipation dans un fluide ? C'est parce que nous avons beaucoup de degrés de liberté. parce que nous avons des tas d'atomes qui circulent, qui se cognent, qui cognent des parois, et qui se mettent en désordre. Dissipation veut dire création de chaleur, création de chaleur et d'entropie veut dire apparition de désordre. Ce qu'il y a de spécial dans les systèmes superfluides, c'est le fait qu'ils comportent des particules individuelles que nous appelons des bosons, et que ces particules individuelles acceptent de pouvoir être, en nombre arbitrairement grand dans un même état quantique. En particulier, à basse température, les bosons se mettent tous dans l'état le plus bas que le système peut leur offrir. Le résultat, c'est que nous avons un état quantique qui contient 1023: ici les manifestations de la physique quantique, au lieu d'être liées à des observations très fines, à l'échelle de l'atome, deviennent des manifestations visibles macroscopiquement, à l'échelle du centimètre. Et nous avons peu de degrés de liberté : toutes les particules dans un même état ! Ceci fait que nous n'avons plus moyen de dissiper. Ça, c'est l'idée extraordinaire de Fritz London. Elle se heurtait toutefois à certaines difficultés ; en particulier, pour le cas des métaux supraconducteurs, les particules de base sont des électrons qui ne sont pas du tout des bosons, pourquoi diable irait-on invoquer des bosons ! La réponse est venue du physicien américain Léon Cooper, en 1957. Il a compris qu'une interaction arbitrairement faible, de type attractif entre électrons, les groupait en paires et de fait créait des bosons avec la statistique désirée.

L'homme qui a vraiment compris la superfluidité est Fritz Londoii qui a pensé à lier cette propriété à un effet de statistique. Celà vaut peut-être la peine de passer une minute là-dessus. Habituellement, pourquoi est-ce que nous avons de la dissipation dans un fluide ? C'est parce que nous avons beaucoup de degrés de liberté. parce que nous avons des tas d'atomes qui circulent, qui se cognent, qui cognent des parois, et qui se mettent en désordre. Dissipation veut dire création de chaleur, création de chaleur et d'entropie veut dire apparition de désordre. Ce qu'il y a de spécial dans les systèmes superfluides, c'est le fait qu'ils comportent des particules individuelles que nous appelons des bosons, et que ces particules individuelles acceptent de pouvoir être, en nombre arbitrairement grand dans un même état quantique. En particulier, à basse température, les bosons se mettent tous dans l'état le plus bas que le système peut leur offrir. Le résultat, c'est que nous avons un état quantique qui contient 1023: ici les manifestations de la physique quantique, au lieu d'être liées à des observations très fines, à l'échelle de l'atome, deviennent des manifestations visibles macroscopiquement, à l'échelle du centimètre. Et nous avons peu de degrés de liberté : toutes les particules dans un même état ! Ceci fait que nous n'avons plus moyen de dissiper. Ça, c'est l'idée extraordinaire de Fritz London. Elle se heurtait toutefois à certaines difficultés ; en particulier, pour le cas des métaux supraconducteurs, les particules de base sont des électrons qui ne sont pas du tout des bosons, pourquoi diable irait-on invoquer des bosons ! La réponse est venue du physicien américain Léon Cooper, en 1957. Il a compris qu'une interaction arbitrairement faible, de type attractif entre électrons, les groupait en paires et de fait créait des bosons avec la statistique désirée.

Donc, la nature des objets superfluides a été comprise en deux étapes, par London et Cooper. Et puis, naturellement a suivi toute la cascade de calculs que l'on peut imaginer. Le premier métal supraconducteur a été trouvé par le scientifique hollandais Kanimerlingh Onnes (1911), et la compréhension à peu près correcte de la chose, n'est venue qu'en 1957. Ensuite tous, (et moi parmi les autres) nous avons été béats et tranquilles, jusqu'au moment où, il y a deux ans, des matériaux supraconducteurs tout à fait exotiques, qui ne sont pas des métaux, mais des oxydes, sont apparus : avec eux les règles que les théoriciens avaient construites pour se faire une description quantitative de la superfluidité paraissent violées. Mais nous savons tout de même par deux expériences que les nouveaux matériaux ont aussi leurs électrons regroupés en paires.

Je continue ma liste d'objets. Il y en a un que j'aime beaucoup présenté sur la figure 1. Ce que nous avons là, c'est un cristal liquide «nématique» formé de molécules allongées. Ces molécules décident de rester parallèles entre elles à l'état liquide. En principe, si nous avions un spécimen parfait, nous verrions ici une plage absolument uniforme. Mais à cause de différentes contraintes (par exemple, des effets des surfaces extérieures), il apparaît un réseau de lignes singulières, et des points à la rencontre de ces lignes, que nous appelons les noyaux de Georges Friedel. Ces lignes ou ces points singuliers sont devenus importants pour l'ensemble de la science de notre époque. Je vous explique ce qu'est localement une ligne singulière dans un nématique : les molécules s'enroulent autour d'une ligne qui est perpendiculaire au plan du tableau. Ce qui est frappant c'est que, simplement par l'observation d'un tel cliché, on sait qu'on a affaire à un nématique, c'est-à-dire que le défaut est révélateur de la structure sous jacente (une chose que l'on trouve aussi chez les hommes !). L'importance de ces singularités s'est bien clarifiée pendant ces derniers 50 ans. D'abord, avec Georges Friedel (dans les années 30) puis avec Charles Frank (dans les années 60) et enfin avec Gérard Toulouse, qui a construit la description topologique générale de ces défauts (dans les années 75). La notion de ligne singulière touche aussi à des tas d'autres domaines. Dans la situation très curieuse de la physique des hautes énergies, on sait que les particules dites élémentaires de ma jeunesse (les protons, les neutrons) sont en fait formées d'objets plus petits, plus ponctuels, les quarks. C'est quarks sont visibles dans certaines expériences de diffraction, mais ne sont pas séparables, on arrive jamais à en arracher un seul. Quand un quark se sépare de son frère jumeau, cette séparation crée dans l'espace une ligne singulière et l'énergie qu'il faut pour les séparer, en gros, croît linéairement avec la longueur de ligne qu'on produit. Ceci fait qu'on ne les sépare jamais sur des très grandes distances. Je trouve assez extraordinaire, la relation profonde qu'il y a entre des liquides moléculaires comme les nématiques, à un bout, et les constituants de la matière à l'échelle subnucléaire. Et puis, parce que j'aime toujours les super-fluides et les supraconducteurs, je mentionne un autre type de ligne singulière que l'on rencontre dans les supraconducteurs dits de type Il (les supraconducteurs à champ critique élevé, très importants pour la technologie des champs forts et peut-être dans l'avenir, pour la technologie des machines tournantes, des transformateurs). Ces matériaux ont été compris en premier par Shubnikov, en URSS ; malheureusement il n'a pas réussi à faire passer son message, pour deux raisons : l'une est qu'il est mort assez rapidement dans les geôles staliniennes ; l'autre est que l'occident avait un modèle complètement faux, mais accepté, pour les propriétés des alliages auxquels s'intéressait Shubnikov, un modèle qui les voyait comme des systèmes très impurs, piégeant le flux et ainsi de suite. En fait, de nos jours et en particulier grâce aux travaux de Goodmann en France et en URSS d'Abrikosov, on sait que dans la thèse de Shubnikov, le champ magnétique pénètre, autour de lignes singulières où il détruit la supraconductivité (les lignes de vortex). Mais en dehors de ces lignes singulières, le matériau garde sa robustesse superfluide. Typiquement, les distances entre lignes sont de quelques centaines de distances atomiques, ce qui d'ailleurs a posé un problème assez farouche pour leur détection, parce que ces échelles sont parmi les plus difficiles à voir. La première expérience a été faite par Trâuble qui avait eu l'idée très ingénieuse d'envoyer des atomes magnétiques sur la surface supérieure d'un échantillon sous champ ; ces atomes sont attirés par les régions de champ fort et ils forment sur la surface, une carte (que l'on peut après regarder en microscopie électronique) Cette carte qui permet de mettre en évidence le réseau de vortex comme on l'appelle, qui est présent là-dedans . La deuxième expérience est due à Cribier, Jacrot, Farnoux. Elle consiste à diffracter des neutrons sur les vortex, et donc de mesurer leurs espacements. Il y en a eu bien d'autres depuis, mais là, je parle un peu en ancien combattant.

La notion de ligne singulière touche aussi à des tas d'autres domaines. Dans la situation très curieuse de la physique des hautes énergies, on sait que les particules dites élémentaires de ma jeunesse (les protons, les neutrons) sont en fait formées d'objets plus petits, plus ponctuels, les quarks. C'est quarks sont visibles dans certaines expériences de diffraction, mais ne sont pas séparables, on arrive jamais à en arracher un seul. Quand un quark se sépare de son frère jumeau, cette séparation crée dans l'espace une ligne singulière et l'énergie qu'il faut pour les séparer, en gros, croît linéairement avec la longueur de ligne qu'on produit. Ceci fait qu'on ne les sépare jamais sur des très grandes distances. Je trouve assez extraordinaire, la relation profonde qu'il y a entre des liquides moléculaires comme les nématiques, à un bout, et les constituants de la matière à l'échelle subnucléaire. Et puis, parce que j'aime toujours les super-fluides et les supraconducteurs, je mentionne un autre type de ligne singulière que l'on rencontre dans les supraconducteurs dits de type Il (les supraconducteurs à champ critique élevé, très importants pour la technologie des champs forts et peut-être dans l'avenir, pour la technologie des machines tournantes, des transformateurs). Ces matériaux ont été compris en premier par Shubnikov, en URSS ; malheureusement il n'a pas réussi à faire passer son message, pour deux raisons : l'une est qu'il est mort assez rapidement dans les geôles staliniennes ; l'autre est que l'occident avait un modèle complètement faux, mais accepté, pour les propriétés des alliages auxquels s'intéressait Shubnikov, un modèle qui les voyait comme des systèmes très impurs, piégeant le flux et ainsi de suite. En fait, de nos jours et en particulier grâce aux travaux de Goodmann en France et en URSS d'Abrikosov, on sait que dans la thèse de Shubnikov, le champ magnétique pénètre, autour de lignes singulières où il détruit la supraconductivité (les lignes de vortex). Mais en dehors de ces lignes singulières, le matériau garde sa robustesse superfluide. Typiquement, les distances entre lignes sont de quelques centaines de distances atomiques, ce qui d'ailleurs a posé un problème assez farouche pour leur détection, parce que ces échelles sont parmi les plus difficiles à voir. La première expérience a été faite par Trâuble qui avait eu l'idée très ingénieuse d'envoyer des atomes magnétiques sur la surface supérieure d'un échantillon sous champ ; ces atomes sont attirés par les régions de champ fort et ils forment sur la surface, une carte (que l'on peut après regarder en microscopie électronique) Cette carte qui permet de mettre en évidence le réseau de vortex comme on l'appelle, qui est présent là-dedans . La deuxième expérience est due à Cribier, Jacrot, Farnoux. Elle consiste à diffracter des neutrons sur les vortex, et donc de mesurer leurs espacements. Il y en a eu bien d'autres depuis, mais là, je parle un peu en ancien combattant.

Vous voyez, je continue mon chemin erratique parmi les objets que nous offre la nature ; une autre famille importante, c'est ce que nous appelons maintenant les systèmes self-similaires. . (Les colloïdes d'or sont quelque chose que nous devons à Faraday, au siècle dernier. Faraday a su les préparer, a su les stabiliser et ils sont devenus, en un certain sens, un objet classique.) Mais plus récemment, il y a eu une époque passionnante, où on a essayé de voir ce qui se passait quand on déstabilise un tel colloïde. Dans ceux que fabriquait Faraday. qui sont stabilisés par des charges, les grains au lieu de s'attirer par leurs forces de Van der Waals, se repoussent par des charges électrostatiques. Mais si on ajoute du sel, on écrante les interactions électrostatiques entre grains et les grains floculent : la couleur change. Quels sont les objets que l'on forme, dans cette situation d'attraction douce entre grains ? On forme des objets extraordinairement ramifiés, très fragiles. Ici le grain, l'unité élémentaire a 100 angstrôms. La taille totale de l'amas formé par floculation a quelques dizaines de microns. Ces objets, on peut les regarder en grand détail. La propriété la plus importante est la « self-similarité ». C'est le fait que, si l'on isole une partie et qu'on agrandit la photo, on ne peut pas distinguer les propriétés statistiques de cette nouvelle photo de celle de la grande photo dont on était parti. Ces systèmes sont statistiquement les mêmes par un changement d'échelle. Et cette idée-là est une idée qui s'est avérée extrêmement importante pour une large compréhension de la nature.

J'ai cité cet exemple des colloïdes d'or, j'en cite un deuxième sur lequel nous sommes beaucoup moins avancés, mais qui est un défi pour le prochain cinquantenaire, c'est la turbulence développée. On sait très bien que quand on regarde couler la Seine sous le pont Mirabeau, pour suivre un poète fameux, il y a des tourbillons qui se forment et que ces tourbillons, souvent, engendrent d'autres tourbillons. Certaines techniques peuvent décrirece qui se passe derrière un obstacle dans un écoulement hydrodynamique : des tourbillons se forment, au début ce sont des tourbillons alternés réguliers, connus sous le nom de «allées de Benard-von Karman» mais si on va un peu vite, ces tourbillons eux-mêmes sont instables, se décomposent, s'apparient. Pour les écoulements à trois dimensions, a très grand nombre de Reynolds, il y a évolution vers un état ultérieur qui n'est pas représenté sur cette photo où, finalement on arrive à des tourbillons tellement petits qu'on engendre un objet self-similaire. Un autre exemple de système self-similaire est celui que réalisent des chaînes de polymères flexibles quand on les adsorbe sur des surfaces : opération qui est très importante pour protéger les grains colloïdaux, une grande partie des peintures, une partie aussi des produits alimentaires que nous utilisons à notre époque, utilisent cette protection par des chaînes polymériques. Ces chaînes forment une sorte de grille self-similaire. Si vous êtes loin de la paroi, la grille a une grande maille ; si vous êtes deux fois moins loin, la maille est deux fois plus petite, et ainsi de suite. Ce dessin est véritablement le pilote d'un nombre de propriétés extraordinairement élevé. Ces exemples sont très modestes, mais ce sont des exemples importants pour l'ingénierie chimique.

Un autre exemple de système self-similaire est celui que réalisent des chaînes de polymères flexibles quand on les adsorbe sur des surfaces : opération qui est très importante pour protéger les grains colloïdaux, une grande partie des peintures, une partie aussi des produits alimentaires que nous utilisons à notre époque, utilisent cette protection par des chaînes polymériques. Ces chaînes forment une sorte de grille self-similaire. Si vous êtes loin de la paroi, la grille a une grande maille ; si vous êtes deux fois moins loin, la maille est deux fois plus petite, et ainsi de suite. Ce dessin est véritablement le pilote d'un nombre de propriétés extraordinairement élevé. Ces exemples sont très modestes, mais ce sont des exemples importants pour l'ingénierie chimique.

Je passe maintenant à un autre exemple de système self-similaire qui est à une échelle un peu différente. C'est celui des galaxies : quand on regarde comment se répartissent les galaxies observables dans le ciel, on trouve qu'elles ont une structure extraordinairement lacunaire mais en fait un peu le même aspect qu'un colloïde d'or. Et de nos jours, on sait quantifier cette chose-là, caractériser cette distribution par ce qu'on appelle une dimension fractale qui est de l'ordre de 1,2. On trouve cette structure lacunaire, au moins jusqu'à 1 millième de «l'horizon». Pour ce qui se passe à plus grande distance, la dispute est énorme. La majeure partie des astrophysiciens pense que, si on regarde plus loin, on retrouve un milieu qui est sagement uniforme et que l'univers vu à grande échelle, est une boule uniforme de matière. (Et ça les arrange bien, parce que c'est uniquement ces objets-là qu'on sait, un petit peu discuter, du point de vue de la relativité générale !) Mais certains autres arguent que les données à très grande distance ne sont pas du tout concluantes et il est très possible que l'univers à toute échelle, même aux plus grandes échelles, soit un espèce d'objet filamentaire bizarre, et pas du tout l'objet homogène auquel nous pensons habituellement. Donc ces systèmes self-similaires touchent à tout. Beaucoup de choses auxquelles nous avons à faire, dans le très petit et dans le très grand, en dépendent.

Je suis arrivé au bout de cette espèce de voyage sentimental, et je voudrais n'en tirer que des conclusions très modestes ; il y a une conclusion nette, c'est la solidarité des sciences. En particulier, je suis très sensible à la solidarité avec la chimie.La physique et la chimie sont actuellement deux sciences qui ne peuvent pas progresser l'une sans l'autre. Un des gros problèmes c'est que l'éducation se prête mal à la double connaissance de la physique et de la chimie, mais il est évident que notre monde actuel a été bouleversé par l'apparition des polymères, des matières plastiques, qui résulte d'une coopération physique-chimie tout à fait exemplaire. Il est aussi évident que dans les années qui vont venir, le rôle des céramiques va croître ; là encore il y a un domaine tout à fait interdisciplinaire, la synthèse des céramiques nouvelles est quelque chose qui pose des problèmes extrêmement subtils. Donc, la physique et la chimie doivent être traitées comme soeurs jumelles. Et je regrette beaucoup de ne pas avoir eu plus de temps pour vous parler de chimie, mon ignorance m'a rendu un peu timide. On peut dire un peu la même chose du côté des mathématiques. D'une part, les mathématiques, dans notre système français ont eu un poids écrasant, et ont instauré un enseignement dogmatique de la science qui est très très dangereux. D'autre part, il est juste de dire que les mathématiques ont aussi joué un rôle de fécondation extraordinaire, et moi je me rappelle très bien d'un cas que j'aime beaucoup citer. Je me rappelle d'une promenade en vallée de Chevreuse, avec un ami américain, B. Mazur, qui est mathématicien et d'une vague discussion, tout en cueillant des mûres : comment est-ce qu'on pourrait classer le genre de défauts observés par Georges Friedel ? Mazur m'a expliqué, avec patience, qu'il y avait des groupes d'homotopie et qu'on pouvait classer avec eux les propriétés de circuits entourant un défaut. Et moi, dans mon ignorance j'écoutais avec beaucoup de plaisir, mais jamais, jamais je n'étais profondément convaincu que ça allait servir. Le grand mérite de Gérard Toulouse, Maurice Klemane et Louis Michel, quelques années plus tard a été de sentir que les groupes d'homotopie contenaient vraiment la réponse aux questions que les physiciens cherchaient depuis assez longtemps. Il y a des exemples comme cela, en topologie, en statistiques aussi, où le rôle des mathématiques a été extraordinaire, il y a aussi des exemples en sens inverse. C'est très frappant que certaines propriétés de topologie sont engendrées sur des exemples concrets issus de la physique des champs. Donc de ce point de vue, il y a une espèce de circulation qui est assez bonne. Deuxième remarque : au cours de cette excursion en physique, nous avons vu plusieurs «situations de progrès». A un bout, celle du transistor qui est la plus pure, où véritablement la déduction est presque totale. A l'autre bout, je dois citer celle du caoutchouc. Au début du XIX siècle, la situation est la suivante : on extrait le latex des hévéas du Brésil et les Indiens savent en faire des vagues chaussures, simplement en les faisant sécher sur leurs pieds, le résultat est extrêmement médiocre : ils arrivent à réticulé des chaînes, mais au bout de quelques jours, l'oxygène coupe les chaînes et la botte qu'ils s'étaient fait, disparaît complètement, et puis, arrive Monsieur Goodyear (vers 1845). Il a alors l'idée de mélanger du soufre à du latex et puis de chauffer un peu tout ça et il obtient un admirable caoutchouc. Et ce qu'il y a d'effrayant c'est que cette opération chimique réussie (et tout de suite très productive) n'a été, lucidement comprise, qu'à peu près 100 ans après. Voilà donc un cas où la découverte précède vraiment la compréhension profonde d'une façon qui est un peu gênante quand nous réclamons des crédits. Je crois qu'il faut arriver à une espèce d'équilibre entre les deux, il faut être conscient que l'on a besoin des deux types d'opérations, et tout mon espoir est d'arriver à ne pas tuer l'un par l'autre. Nous formons des étudiants français très déductifs, qui n'auraient pas du tout l'idée de mettre du soufre dans du latex.

Deuxième remarque : au cours de cette excursion en physique, nous avons vu plusieurs «situations de progrès». A un bout, celle du transistor qui est la plus pure, où véritablement la déduction est presque totale. A l'autre bout, je dois citer celle du caoutchouc. Au début du XIX siècle, la situation est la suivante : on extrait le latex des hévéas du Brésil et les Indiens savent en faire des vagues chaussures, simplement en les faisant sécher sur leurs pieds, le résultat est extrêmement médiocre : ils arrivent à réticulé des chaînes, mais au bout de quelques jours, l'oxygène coupe les chaînes et la botte qu'ils s'étaient fait, disparaît complètement, et puis, arrive Monsieur Goodyear (vers 1845). Il a alors l'idée de mélanger du soufre à du latex et puis de chauffer un peu tout ça et il obtient un admirable caoutchouc. Et ce qu'il y a d'effrayant c'est que cette opération chimique réussie (et tout de suite très productive) n'a été, lucidement comprise, qu'à peu près 100 ans après. Voilà donc un cas où la découverte précède vraiment la compréhension profonde d'une façon qui est un peu gênante quand nous réclamons des crédits. Je crois qu'il faut arriver à une espèce d'équilibre entre les deux, il faut être conscient que l'on a besoin des deux types d'opérations, et tout mon espoir est d'arriver à ne pas tuer l'un par l'autre. Nous formons des étudiants français très déductifs, qui n'auraient pas du tout l'idée de mettre du soufre dans du latex.

Il y a encore un troisième aspect qui me paraît important c'est ce que j'appelle la patience nécessaire. Je me plais beaucoup à parler de ce laboratoire IBM à Zurich, qui est relativement petit, mais qui a été irrigué, intelligemment pendant plus de 20 ans ; son but premier était, me semble-t-il, de recueillir certains scientifiques allemands qui n'avaient plus de place dans l'Allemagne de l'après guerre, et puis de les hybrider avec des scientifiques spécifiquement suisses et d'améliorer les choses, par cette hybridation. Mais ce qu 'il y a de remarquable, c'est la politique à longue échéance qui a été faite là, où pendant plus de 20 ans, ces gens ont travaillé dans une indépendance complète. Cette indépendance a porté ses fruits sous forme de deux prix Nobel (partagés par quatre chercheurs) qui ont été un peu évoqués ici, un sur le microscope tunnel, l'autre sur les nouveaux supraconducteurs. Eh bien je crois que c'est un exemple de patience nécessaire qu'il est très important de citer aux décideurs. Peu de compagnies, de nos jours, ont à la fois la puissance économique et la puissance intellectuelle nécessaires pour arriver à faire ce genre de pari à longue échéance - en chimie, je crois que Dupont de Nemours y parvient, mais il n'y en a pas beaucoup d'autres.

Un autre exemple de patience nécessaire est celui des verres de spin. Par exemple, on met quelques atomes magnétiques (du manganèse) dans une matrice de cuivre et ces atomes se couplent entre eux par des couplages bizarres et antagonistes ; la situation est telle que personne ne parvient au bonheur. Si on les met tous parallèles, ils ne sont pas contents, si on les met en ordre alterné, ils ne sont pas contents non plus, et leur forme de bonheur est infiniment plus torturée, c'est ce qu'on appelle d'ailleurs, dans un langage très actuel, une situation de frustration. Par exemple, trois spins n'arrivent pas à trouver une orientation qui les rende parfaitement heureux. Cette physique des verres de spin, au début, je l'ai suivie avec amusement et puis après, avec un certain énervement. J'avais l'impression que la communauté s'égarait dans une voie de magnétisme hyperraffiné, un peu rococo. En fait, j'avais complètement tort, et ceci je ne l'ai compris que bien plus tard, parce qu'il s'est avéré, progressivement, grâce à deux inventeurs remarquables (Hopfield et Little) que les mêmes concepts qui s'appliquent à ces systèmes de spins frustrés permettent de mieux comprendre des systèmes de neurones couplés, avec des multi-interactions antagonistes, d'où les meilleurs modèles disponibles pour le fonctionnement de certaines parties du cerveau. C'est d'ailleurs extraordinaire de voir le curriculum de Hopfield et de Little et cela revient à mon premier point, la solidarité des sciences, Hopfield, au départ, s'intéressait à l'optique des molécules, Little, lui, a commencé par les supraconducteurs. Il a passé dix ans de sa vie à essayer de faire des supraconducteurs avec des complexes métalliques dans des situations étranges, sans succès ! Récemment, Little a fondé une compagnie privée avec laquelle il fait de la microcryogénie, pour des études sur systèmes spatiaux : cette espèce de triple vocation de Little montre bien la solidarité des sciences.

J'ai presque fini ces remarques sur nos cinquante années. Comme plusieurs l'ont déjà mentionné, j'ai personnellement beaucoup appris au Palais de la Découverte, au Palais des années quarante-huit. J'y retourne avec mes enfants, je vais y retourner bientôt avec mes petits-enfants, et je suis tout à fait convaincu que la flamme est la même. En particulier, je pense à cette exposition sur les insectes qui est à côté, et qui a un succès extraordinaire. C'est un très, très grand bonheur de voir de petits enfants avec leurs yeux grand ouverts devant l'intérieur d'une ruche. Peut-être le plus grand bonheur qu'il y a dans la recherche que nous faisons, c'est d'arriver ensuite, à éveiller cette petite flamme chez eux, par exemple à propos de cinquante ans de physique.

...par Pierre Gilles de Gennes à l'occasion des 50 ans du Palais de la Découverte (Paris)