Cosmologie La cosmologie est la science dont l’objet d’étude est l’Univers, sa structure, sa formation et son évolution... tout un monde à découvrir ! |

Sommaire du dossier

Introduction : l'Univers de la cosmologie

La théorie du Big Bang

Formation et structure de l'univers actuel

Compléments : aperçu de la théorie de la relativité générale

Références

Bloc notes

| 1. Introduction : l'Univers de la cosmologie |

|---|

La cosmologie est la science dont l’objet d’étude est l’Univers, sa structure, sa formation et son évolution. Etudier l’Univers suppose que celui-ci puisse être assimilé à un objet physique à part entière dont le comportement obéit à des lois au même titre qu’une particule élémentaire ou qu’une goutte d’eau. Cette hypothèse fondatrice de la cosmologie est pourtant hardie car qu’est-ce que l’Univers sinon le Tout, c'est-à-dire à la fois l’espace, le temps et la matière, en d’autres mots la trame même des lois physiques ? Le tout peut-il être un objet obéissant aux mêmes lois - tout au moins à des lois de même nature - que ses constituants ? Les fondements de la cosmologie moderne sont en permanence confrontés à ce paradoxe incontournable.

Face à la complexité d’un Univers démesurément grand et définitivement inaccessible, les physiciens ont posé un axiome simplificateur connu sous le nom de principe cosmologique. En rejetant l’idée que la Terre pouvait occuper une position privilégiée dans l’Univers, Copernic [1] et son système planétaire héliocentrique ont jeté les bases du principe cosmologique. En fait, l’intuition copernicienne peut être étendue à tout point et à tout instant de l’Univers ce qui conduit à l’énoncé suivant du principe cosmologique : à grande échelle l’Univers est homogène et isotrope.

A l’échelle de l’Univers la physique est soumise au pouvoir absolu et sans partage de la gravitation. Cette dynamique permet de décrire l’évolution du « contenu » de l’Univers mais ne nous renseigne pas sur l’Univers lui même. En effet, la mécanique classique renvoie l’image d’un espace et d’un temps statiques, comme une scène immuable et inaltérable où se joue la physique. Il fallut attendre Albert Einstein et la théorie de la relativité générale pour que la « scène » prenne part à l’action et que l’Univers accède au statut d’objet physique.

Armée du principe cosmologique et de la relativité générale, la cosmologie put enfin se lancer à la découverte de l’histoire de l’Univers.

| 2. La théorie du "big bang" |

|---|

La loi de Hubble

En 1925, Edwin Hubble [2] découvrit l’existence d’autres galaxies dans l’Univers, alors qu’auparavant les astronomes pensaient que l’Univers se limitait à la voie lactée. Cette découverte sensationnelle mit en évidence un Univers immense dont les dimensions dépassaient l’entendement. Hubble constata de plus que le spectre d’émission des galaxies semblait d’autant plus décalé vers le rouge que celles-ci étaient éloignées. En 1929, il proposa d’interpréter ce décalage par une « fuite » des galaxies ; le décalage lui-même étant le résultat de l’effet Doppler [3]. Il établit une relation très simple de proportionnalité entre la vitesse d’éloignement des galaxies et leur distance à la Terre connue sous le nom de loi de Hubble :

ve = H0.d

où ve est la vitesse d’éloignement de la galaxie, d sa distance à la Terre et H0 une constante de proportionnalité baptisée constante de Hubble.

Quelle interprétation donner à la loi de Hubble ? Pourquoi les galaxies s’éloignent-elles toutes de la Terre ? Faut-il en conclure que la Terre occupe une position centrale dans l’Univers ?

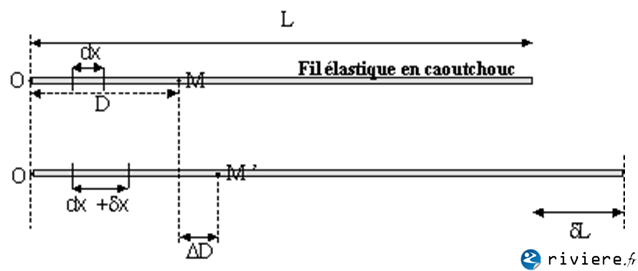

Considérons un fil élastique en caoutchouc. Étirons ce fil avec une vitesse uniforme, les points se sont déplacés les uns des autres avec une vitesse uniforme. Par rapport à chaque point, tous les autres points du fil semblent s’éloigner. Prenons un point quelconque O comme point de repère et calculons la vitesse d’éloignement d’un point M situé initialement à une distance D de O.

Modèle du fil élastique

Soient L la longueur du fil et dL la valeur de son étirement total pendant l’intervalle de temps dt. Soit dx un élément du fil de longueur infinitésimale ; celui-ci s’étire de la quantité

![]()

Soit M’ la position du point M après l’étirement. La distance OM’ vaut :

![]()

L’accroissement de la distance entre O et M s’exprime :

![]()

et la vitesse d’éloignement apparente de M par rapport à O est alors :

![]()

On retrouve une relation qui est exactement de la même forme que celle de la loi de Hubble (voir également le problème « l’Univers en expansion » au paragraphe 6.4). Notamment, deux points situés sur le fil s’éloignent d’autant plus vite qu’ils sont distants. Dans un tel modèle, aucun point ne possède de position privilégiée sur le fil et pourtant pour chacun d’eux les autres points semblent s’éloigner. Ce modèle simple, à une dimension, permet de rendre compte des principales propriétés du comportement des galaxies dans l’Univers.

Quel lien existe-t-il entre le modèle du fil en caoutchouc et le décalage du spectre d’émission des galaxies vers le rouge ? En relativité générale, les propriétés géométriques de l’espace-temps reposent sur le concept de métrique. La métrique d’un espace peut se définir comme les « ingrédients » mathématiques qui déterminent la distance entre deux points dans cet espace. La métrique étalonne l’espace. En géométrie euclidienne ces ingrédients sont figés c'est-à-dire que la formulation de la distance entre deux points est identique quelle que soit leur position dans l’espace. Il n’en est pas de même en relativité générale qui définit une métrique comme étant « malléable » ou « élastique » à la manière d’un « matériau » en caoutchouc ou d’un fluide qui peut être « étiré », « comprimé » voire même « tordu » (voir les compléments à la fin et le problème « l’Univers en expansion »).

La fuite des galaxies - et par là même le décalage vers le rouge - peut alors être interprétée comme la manifestation concrète de « l’étirement » de la métrique de l’espace-temps relativiste. En étendant les résultats obtenus à l’aide de notre modèle du fil élastique à l’espace-temps, la constante de Hubble s’interprète alors comme la valeur de l’expansion de l’espace-temps par unité de temps en chaque point de l’Univers ! Pour donner un support visuel en deux dimensions à l’expansion de l’Univers - qui s’effectue en trois dimensions - imaginons un ballon de baudruche que l’on gonfle. La surface de la baudruche s’étire uniformément ce qui se traduit par un éloignement relatif de chacun de ses points. Cette image procède du même principe que le modèle du fil élastique : l'étirement du support géométrique de référence.

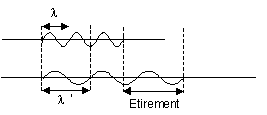

Dans le cadre d’une interprétation géométrique du décalage vers le rouge du spectre des galaxies, l’effet Doppler trouve une explication originale : « l’étirement » de l’espace-temps aurait pour effet « d’étirer » les ondes lumineuses, faisant ainsi croître leur longueur d’onde ce qui induit un décalage vers les basses fréquences c'est-à-dire vers le rouge. Sur la figure suivante, on voit qu’après « étirement » de l’espace, la longueur d’onde de l’onde a augmenté.

Interprétation de l’effet Doppler-Fizeau dans un Univers en expansion

La constante de Hubble H0 nous informe très précisément sur la vitesse d’expansion de l’Univers. La mesure de la valeur de cette constante représente donc un enjeu majeur de la cosmologie moderne. La valeur de H0 est donnée par le rapport de la vitesse d’éloignement des galaxies par leur distance à la Terre. Si la première grandeur peut être obtenue facilement en analysant les spectres d’émission des galaxies, la seconde en revanche est en général inconnue. Les techniques d’appréciation des distances dont disposent les astrophysiciens reposent sur l’analogie : en comparant la luminosité d’une galaxie dont l’éloignement est inconnu à celle d’une galaxie en apparence semblable et dont la distance à la Terre est connue, ils peuvent en déduire, très empiriquement, la distance de la première. Cette façon de procéder présente de nombreuses imperfections et dans ces conditions il n’est pas étonnant de rencontrer un profond désaccord au sein du monde de l’astrophysique sur la valeur de H0. Les mesures actuelles donnent à H0 une valeur comprise entre 50 et 100 km.s-1.Mparsec-1 (1 parsec = distance à laquelle le rayon moyen de l’orbite terrestre est vu sous un angle de 1 seconde d’arc = 3,36 années de lumière = 3,09.1016 m).

L’hypothèse du « Big Bang » chaud

En 1915, Albert Einstein publie ses travaux sur la relativité générale. Sans entrer ici dans le détail, l’un des résultats les plus importants de cette théorie est la nouvelle formulation de la gravitation par l’équation d’Einstein. Au travers de cette équation, la gravitation s’interprète comme une courbure de l’espace-temps qui a pour effet de courber la trajectoire des corps (voir le complément sur la relativité générale à la fin de ce chapitre, au paragraphe 6.5). La géométrie de l’espace-temps est entièrement déterminée par la masse et l’énergie qu’il contient (en fait par la densité de ces grandeurs car l’équation d’Einstein est locale).

De Sitter [4] résolut l’équation d’Einstein dans le cas d’un Univers vide. Les solutions qu’il obtint étaient celles d’un Univers en expansion, ce qui peut paraître paradoxal pour un Univers vide de matière. Friedmann [5] peaufina ce modèle en y introduisant de la matière mais en supposant que celle-ci était répartie de manière homogène et isotrope (principe cosmologique). Ses travaux furent complétés par Lemaître [6] qui finalement, en 1933, énonça l’hypothèse que l’Univers, à son origine, a pu se trouver concentré dans un volume réduit à un point qu’il baptisa l’atome primordial. Cette théorie très audacieuse fut reprise et approfondie par Gamow [7] et fut baptisée, par l’un de ses détracteurs (Hoyle) en guise de boutade, la théorie du « Big Bang ».

La théorie du « Big Bang » est une théorie de l’évolution de l’Univers qui propose que celui-ci est le résultat d’une « explosion » originelle de l’espace-temps suivie d’une expansion. Il faut manipuler le terme « explosion » avec beaucoup de précautions : il ne s’agit en aucun cas d’un éclatement accompagné d’une déflagration mais plutôt d’une rapide expansion ou extension de quelque chose qui préexistait. Il est également faux de croire que le « Big Bang » eut lieu en une région particulière de l’espace-temps. En fait, il eut lieu partout à la fois car la totalité de l’espace-temps a été soumis à la même expansion. Dans quel état se trouvait l’Univers avant le « Big Bang » ? La science ne peut répondre à cette question car les conditions physiques qui régnaient alors ne peuvent être décrites par le moyen des théories actuelles.

Si l’on admet que l’Univers originel était concentré en un seul point (l’atome primordial de Lemaître) il est alors possible de calculer un ordre de grandeur du temps mis par un point donné pour se trouver à sa position actuelle. Pour ce faire, nous supposerons que la vitesse d’expansion de l’Univers est constante au cours du temps. Un point situé à une distance D de la Terre aura mis le temps tU dont la valeur est :

![]()

où ve est la vitesse d’éloignement du point. tU est appelé le temps de Hubble. On notera que ce temps est indépendant du point considéré et fournit donc l’âge de l’Univers depuis le « Big Bang ». En fait, rien ne permet de supposer que la vitesse d’expansion de l’Univers est une constante. Bien au contraire, l’observation des galaxies les plus lointaines (donc les plus anciennes) nous montre que le décalage vers le rouge est supérieur à celui prédit par la loi de Hubble, ce qui pourrait signifier que la valeur de H0 a décru avec le temps. En tenant compte de cette remarque, le temps tU ne représenterait qu’une limite supérieure de l’âge de l’Univers ce qui nous conduit, compte tenu des incertitudes pesant sur H0, à une valeur comprise entre 10 et 20 milliards d’années (voir le problème « l’Univers en expansion »).

Gamow étudia les propriétés thermodynamiques d’un Univers issu du « Big Bang ». En supposant que l’Univers était une gigantesque cavité parfaitement étanche (l’extérieur de l’Univers étant le néant cette hypothèse est donc physiquement valide !) se trouvant en équilibre thermodynamique, il en tira la conclusion que, d’après la loi du rayonnement du corps noir, l’Univers devrait alors être le siège d’ondes stationnaires emplissant la totalité de son volume.

La théorie du rayonnement du corps noir montre que pour une cavité en équilibre thermodynamique, le produit du volume par la température au cube est une constante (V.T3 = Constante). En combinant cette relation à l’hypothèse d’un Univers en expansion, on en vient à conclure que l’Univers se refroidit et que, par conséquent, il fut plus chaud dans le passé, d’où le qualificatif de théorie du « Big Bang » chaud. Gamow prédit, par le calcul théorique, la température de ce rayonnement « résiduel » qui baigne l’Univers. Il l’estima aux environs de 5 K !

Le rayonnement fossile de l’Univers

L’hypothèse de Gamow aurait pu rester un rêve d’astrophysicien si un jour de 1964, deux ingénieurs des laboratoires Bell, Wilson [8] et Penzias [9], n’avaient découvert, par un pur hasard, un rayonnement isotrope dont le spectre suivait exactement celui d’un corps noir porté à une température de 2,73 K !

Quelques aspects de la loi du corps noir

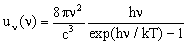

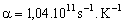

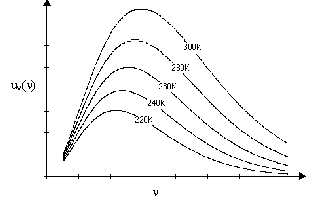

La loi du corps noir décrit le comportement du rayonnement électromagnétique lorsqu’il est en équilibre thermique avec la matière. Elle précise la répartition spectrale de la densité volumique totale d’énergie électromagnétique. On note uv(v) la densité spectrale correspondante, telle que la densité volumique d’énergie électromagnétique du(v) entre les fréquences v et v + dv s’écrit du(v) = uv(v).dv. Le physicien Planck a établi à la fin du XIXe siècle que la densité spectrale uv(v) pouvait s’écrire :

La figure ci-dessous donne le graphe des courbes associées à uv(v) à différentes températures. On établit que ces courbes passent toutes par un maximum qui dépend de la température pour une fréquence vmax(T) qui suit la loi de Wien :

avec

Il est remarquable de noter que le spectre de rayonnement d’un corps noir est continu et ne dépend pas de la nature physico-chimique de celui-ci mais uniquement de sa température. Ces propriétés sont une conséquence directe de l’état d’équilibre thermique dans lequel se trouve le corps. Les spectres d’émission et d’absorption des atomes sont discontinus. Quand un corps est chauffé, il émet un rayonnement dans les bandes de son spectre d’émission. Or, les spectres d’émission et d’absorption d’un atome sont identiques. Il s’ensuit qu’à l’équilibre thermique, les atomes situés à l’intérieur d’un corps absorbent tout le rayonnement qu’ils émettent. Il ne reste plus dans le corps qu’un rayonnement dont le spectre est continu et qui résulte de son état thermodynamique.

Exemple : le maximum de la lumière solaire visible à la surface de la Terre se situe dans le jaune-vert, pour une longueur d’onde voisine de 483 nm, soit une fréquence vmax = 6,2.1014 s-1. Ce rayonnement est celui d’un corps noir de température T = vmax/alpha ≈ 6000 K, correspondant à la température de surface du Soleil.

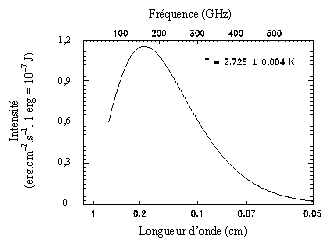

Selon la théorie du « Big bang » chaud, quelques 700.000 ans après « l’explosion » originelle, la température de l’Univers chuta jusqu’aux environs de 3000 K. A cette température les premiers atomes purent se constituer, liant les électrons jusqu’alors libres aux protons et aux noyaux de deutérium, de tritium et d’hélium qui avaient été « fabriqués » par fusion des protons et des neutrons pendant les premières minutes de l’Univers. A ce moment précis, le rayonnement électromagnétique qui emplissait l’Univers et qui vibrait « à l’unisson » avec les particules, se découpla de celles-ci. En effet, les atomes n’ont pas un spectre de vibration (absorption et émission) continu mais discontinu . Il s’ensuivit que pour la plupart des photons, l’Univers fut tout à coup « transparent », c'est-à-dire totalement perméable. C’est ce rayonnement de fond qu’ont observé Penzias et Wilson, reliquat de la fournaise du « Big Bang ». L’expansion de l’Univers s’est ensuite chargée d’en étirer la longueur d’onde et d’en faire décroître la température jusqu’à 2,73 K.

Spectre du rayonnement de corps noir de l’Univers. Mesures effectuées par le satellite COBE (Cosmic Background Explorer)

Que ce rayonnement de fond soit isotrope nous indique qu’au moment où le découplage entre la matière et le rayonnement se produisit, la densité de matière était parfaitement uniforme. Mais alors, comment expliquer la formation de grandes concentrations de matière telles que les galaxies qui nécessite une densité de matière non homogène ?

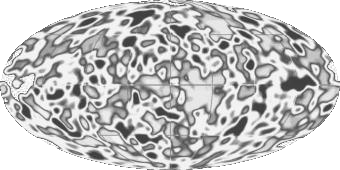

Fluctuations du rayonnement fossile de l’Univers mesurées par COBE. Les variations d’intensité de gris mettent en évidence des différences de l’ordre de 10-5 K

Pour vérifier l’isotropie du rayonnement fossile, les astrophysiciens ont lancé le satellite COBE (Cosmic Background Explorer [10]). La mission de COBE était de mesurer avec une très grande précision la température du rayonnement fossile dans toutes les directions et de s’assurer de l’existence d’imperceptibles fluctuations. En d’autres mots, COBE devait établir une carte du ciel tel qu’il était il y a 10 milliards d’années, ce qu’il fit avec succès. Il détecta en effet de très faibles variations de température (de l’ordre de 10-5 K) d’une région à une autre de l’Univers (voir la figure précédente). Ces légères variations pourraient donc représenter les embryons des galaxies d’aujourd’hui.

A l’automne 2000 le satellite MAP [11] a été lancé pour mesurer avec une plus grande définition les fluctuations du rayonnement fossile de l’Univers. Les mesures obtenues devaient apporter de nombreux renseignements aux astrophysiciens.

| 3. Formation et structure de l'univers actuel |

|---|

Les grandes phases de la formation de l'Univers

La théorie du « Big Bang » telle que Lemaître et Gamow l’ont décrite dans leurs travaux permet de rendre compte de nombreuses observations astronomiques. Cependant, plus on se rapproche du moment du « Big Bang » et plus les conditions physiques rencontrées nécessitent un traitement qui dépasse le cadre des cosmologies du début du siècle. Pour s’en convaincre il suffit de jeter un bref coup d’œil sur l’aspect de l’Univers, un centième de seconde après le « Big Bang » : la température qui y régnait aurait été de l’ordre de 1011 K, pour une densité de matière 3,8 milliards de fois plus élevée que celle de l’eau ! Les interactions mises en jeu à de tels niveaux d’énergie appartiennent au domaine de la physique des particules des hautes énergies. Le cadre théorique devient celui de la physique des particules, plus précisément celui d’un modèle qui décrit les interactions à très hautes énergies : le modèle standard qui valut le prix Nobel à ses créateurs Glashow [12], Salam [13] et Weinberg [14] en 1974.

Nous n’entrerons pas ici dans le détail du modèle standard car les connaissances requises pour en comprendre les tenants et les aboutissants dépassent très largement le cadre et le niveau de ces pages. Nous nous contenterons d’en brosser les principales étapes.

Le modèle standard d’évolution de l’Univers commence par un plongeon dans la complexité du monde de la physique des particules aux très hautes énergies. Outre le fait que cette physique est très complexe, elle reste encore très spéculative car ses bases n’ont pu être à ce jour vérifiées expérimentalement tant les énergies mises en jeu sont considérables. Nous commençons notre voyage dans le passé de l’Univers par un retour en arrière jusqu’à 10-35 seconde après le « Big Bang ».

t = big bang + 10-35 s, T = 1028 K : la fin de la grande unification

Les particules élémentaires sont sensibles à quatre interactions : les interactions forte, faible, électromagnétique et gravitationnelle. A une température de 1028 K, ce qui correspond à une énergie de ~1014 GeV, les interactions forte, faible et électromagnétique n’en constitueraient qu’une décrite par une théorie baptisée la grande unification (Grand Unified Theory ou GUT). Cela signifie que toutes les particules - à l’exception de l’hypothétique graviton, quantum de l’interaction gravitationnelle - interagissent selon les mêmes mécanismes. En dessous de cette température, l’interaction unifiée se « brise » en deux interactions : l’interaction forte d’un côté et l’interaction électrofaible (interaction unifiant les interactions faible et électromagnétique) de l’autre. Le monde des particules se différencie alors en deux familles de particules : les quarks qui sont sensibles aux interactions forte et électrofaible d’une part, et les leptons (électrons, muons, neutrinos) qui sont uniquement sensibles à l’interaction électrofaible d’autre part.

t = big bang + 10-11 s, T = 1015 K : la transition électrofaible

Au dessus de 1015 K - qui correspond à une énergie de ~102 GeV, soit des énergies accessibles par les accélérateurs de particules actuels - les interactions faible et électromagnétique ne se distinguent pas : elles sont unifiées en une seule interaction. Le cadre théorique qui décrit cette interaction unifiée s’appelle le modèle standard. En dessous de cette température, l’interaction unifiée dite électrofaible se « brise » en deux interactions : l’interaction faible d’un côté et l’interaction électromagnétique de l’autre.

t = big bang + 10-6 s, T = 1012 K : la transition quarks-hadrons

Nous savons aujourd’hui que les particules comme les protons et les neutrons (qui appartiennent à la famille des hadrons) sont composées de particules plus élémentaires, les quarks. Certains hadrons sont constitués de trois quarks - les baryons - d’autres n’en contiennent que deux - les mésons. Les quarks se trouvent dans un état lié dans les hadrons. Les particules qui assurent le lien entre les quarks s’appellent des gluons [15]. A une température d’environ 1012 K ou 150 MeV [16], les quarks et les gluons peuvent se trouver à l’état libre dans un plasma quark-gluon. En deçà de cette énergie, les quarks s’assemblent entre eux pour constituer des hadrons. Lorsque la température de l’Univers passa sous la barre des 150 MeV, un tel phénomène se produisit, donnant ainsi naissance à la famille des hadrons. Dans cette famille de particules, les neutrons et les protons sont parmi les plus légères et les plus stables. Il s’ensuit que l’Univers se peupla surtout de ces particules-là. Il est remarquable de noter qu’après la transition quarks-hadrons, quasiment tous les ingrédients de l’Univers actuel étaient donc présents, et ceci 10-6 s seulement après le big bang !

t = big bang + 10-2 s, T = 109 K : la désintégration des neutrons

Les neutrons, tout en étant plus stables que bon nombre de hadrons, finissent cependant par se désintégrer. Ceci survînt 10-2 s après le big bang : les neutrons se désintégrèrent massivement laissant un très important surnombre de protons, alors que les deux populations étaient égales en nombre juste après la transition quarks-hadrons. Une fois de plus ce phénomène est remarquable car il explique pourquoi l’élément le plus répandu dans l’Univers est l’hydrogène (dont le noyau est un proton).

t = big bang + 1 s, T = 106 K : la nucléosynthèse des éléments légers

A une température inférieure à 106 K les protons et les neutrons peuvent se lier entre eux pour former des noyaux légers : deutérium, tritium, hélium, lithium. Au dessus de cette température, l’énergie est supérieure à l’énergie de liaison des protons et des neutrons ce qui empêche donc les noyaux d’exister. Les proportions des différents noyaux légers dans l’Univers prédites par le modèle standard cosmologique sont en bon accord avec les observations des astrophysiciens.

t = big bang + 3 minutes, T = 3000 K : la recombinaison

Ce phénomène a déjà été expliqué plus haut. Trois minutes après le big bang, la température devînt suffisamment basse pour permettre aux noyaux de piéger dans leur champ électrique des électrons. Les atomes venaient de naître. L’Univers prend alors la forme physico-chimique qu’il possède quasiment encore aujourd’hui. Seuls les éléments plus lourds issus de la nucléosynthèse opérée dans les étoiles sont absents.

Les faibles variations originelles de densité de matière vont favoriser par-ci par-là l’agglomération de la matière en boules de gaz plus ou moins massives. Sous la pression gravitationnelle croissante, les plus grosses d’entre elles vont s’allumer des feux thermonucléaires et illuminer le vide de la lumière des premières étoiles. Ainsi naquirent les galaxies et leurs myriades d’étoiles.

| 4. Compléments : aperçu de la théorie de la relativité générale |

|---|

La transformation de Lorentz

En mécanique classique l’espace est euclidien et absolu, c'est-à-dire qu’il ne dépend pas des corps qui s’y meuvent. Ainsi, tout corps peut être repéré par ses coordonnées cartésiennes une fois qu’une origine, arbitraire, est fixée à l’espace.

Le temps, quant à lui, joue le rôle mathématique d’un paramètre : il permet de noter l’évolution des coordonnées et des variables dynamiques d’un système. Comme l’espace, le temps possède en mécanique classique un caractère absolu dans le sens où, une fois son origine fixée, il s’applique de manière identique à tous les corps. Physiquement, cette conception du temps revient à dire que des horloges synchronisées à un instant initial le resteront éternellement et ceci quelles que soient leurs positions dans l’Univers.

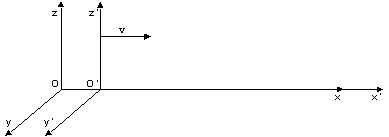

Soient un premier référentiel galiléen R(O,x,y,z) et un second R’(O’,x’,y’,z’) dont l’axe O’x’ est confondu avec l’axe Ox et animé d’une vitesse v par rapport à R colinéaire à Ox.

La transformation des coordonnées de R’ à R est donnée par les relations dites transformations galiléennes :

x = x’ + v.t

y = y’

z = z’

t = t’

En appliquant cette transformation aux lois de la mécanique classique on constate que ces dernières restent inchangées, c'est-à-dire qu’elles s’expriment de la même manière dans tous les référentiels galiléens. Un physicien situé dans le référentiel R et un autre dans le référentiel R’ décriront les lois physiques avec les mêmes équations. Chacun d’eux pensera être immobile et verra l’autre se déplacer. Ce que nous disent les transformations galiléennes c’est qu’aucun des deux référentiels ne peut être considéré comme un référentiel absolu puisque les relations entre les grandeurs physiques sont identiques dans tous les référentiels galiléens. Ce principe est connu sous le nom de principe de relativité galiléen. Le mouvement galiléen est relatif.

Au XIXe siècle les physiciens constatèrent qu’une importante catégorie de phénomènes physiques violait le principe de relativité galiléen : les phénomènes électromagnétiques.

En appliquant les transformations galiléennes aux équations de Maxwell on obtient un jeu d’équations différent selon que l’observateur se trouve dans un référentiel fixe ou un référentiel mobile. Par exemple, considérons un électron. Dans le référentiel qui lui est lié (le référentiel propre) le seul phénomène électromagnétique observable est le champ électrique dont l’électron est la source. Dans un référentiel galiléen mobile par rapport à l’électron, celui-ci devient également la source d’un champ magnétique. Il en découle que les lois de l’électromagnétisme varient d’un référentiel galiléen à un autre ou, en d’autres mots, que les équations de Maxwell ne sont vraies que dans un seul référentiel, un référentiel de référence absolu. Or, comme nous l’avons vu en analysant la relativité galiléenne, il n’est pas possible de distinguer un référentiel galiléen d’un autre car le mouvement uniforme est un phénomène physique relatif. Ces remarques nous conduisent à conclure que :

soit les équations de Maxwell sont fausses,

soit les transformations galiléennes sont inexactes,

ou enfin que notre compréhension du mouvement est incomplète.

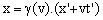

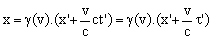

H. Lorentz [17] tenta de trouver pour quelles transformations de R’ à R les lois de l’électromagnétisme restaient identiques. Il obtint le résultat suivant [18] :

avec c la vitesse de la lumière et

Cette loi de transformation amène les deux remarques suivantes :

elle diffère notablement de la loi de transformation galiléenne,

le temps est soumis à une transformation au même titre que les coordonnées spatiales ce qui implique qu’il varie d’un référentiel galiléen à un autre.

Ces lois de transformations sont connues sous le nom de transformations de Lorentz. Il est important de noter que pour des vitesses très inférieures à c, ces relations de transformation se ramènent aux transformations galiléennes.

La relativité restreinte

Albert Einstein n’admettait pas la violation du principe de relativité galiléenne par l’électromagnétisme. De son point de vue il fallait au contraire le généraliser à toutes les lois physiques. Il postula que les lois physiques doivent être identiques dans tous les référentiels galiléens ce qui implique, implicitement, que du point de vue des lois physiques, il n’est pas possible de distinguer un référentiel galiléen d’un autre. Ce principe fut baptisé principe de relativité restreinte (cette relativité est en effet restreinte aux cas des référentiels galiléens exclusivement).

Énoncé du principe de relativité restreinte : les lois physiques sont inchangées après un changement de référentiel galiléen ou encore, les lois physiques sont identiques dans tous les référentiels galiléens.

L’invariance de la vitesse de la lumière (expérience de Michelson et Morley) :

Les équations de Maxwell mettent en évidence l’existence d’ondes électro-magnétiques qui furent effectivement découvertes par Hertz en 1887. D’après les résultats de la mécanique, une onde résulte de la propagation d’une vibration dans un milieu élastique. Ce sont les propriétés élastiques du milieu qui permettent à la vibration initiale de se propager de loin en loin. Or, les ondes électromagnétiques peuvent se déplacer dans le vide c'est-à-dire en l’absence de matière donc de support élastique ce qui défiait, au XIXe siècle, les fondements mêmes du concept d’onde. Pour palier cette difficulté les physiciens postulèrent que le vide n’était pas vide mais contenait un matériau inconnu qu’ils surnommèrent l’éther. Il est important de noter que les physiciens de l’époque n’attribuaient pas à l’éther de propriétés comparables à celle de la matière ordinaire ; sa principale caractéristique était de constituer le support élastique propice à la propagation des ondes électromagnétiques. En ce sens l’éther revêtait une nature plutôt abstraite. Néanmoins, il devait obéir aux lois de la mécanique classique. Notamment, l’éther étant censé être fixe, la loi de composition des vitesses devait s’appliquer aux rayons lumineux.

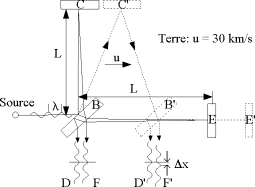

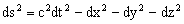

Expérience de Michelson et Morley. Les chemins empruntés par les rayons lumineux lors du déplacement de la Terre sont représentés en pointillés. La vitesse de la Terre ajoutée à celle de la lumière aurait dû engendrer des interférences qui ne furent jamais observées.

En 1887 Michelson [19] et Morley [20] entreprirent de mesurer la vitesse longitudinale de la Terre dans son mouvement de rotation autour du Soleil. Pour cela ils imaginèrent un dispositif expérimental (voir le schéma ci-dessus) fondé sur le différentiel de vitesse entre deux rayons lumineux issus de la même source dont l’un se déplace dans le sens de la vitesse longitudinale de la Terre et l’autre dans la direction perpendiculaire. La différence de vitesse devait se traduire par un déphasage des deux rayons lumineux et, en les faisant interférer, par une figure d’interférences. La mesure de l’interfrange aurait permis de connaître avec précision la vitesse longitudinale de la Terre.

L’expérience fut réalisée et aucune figure d’interférences ne fut observée. En d’autres termes, les deux rayons lumineux se propageaient à la même vitesse ! Après avoir refait plusieurs fois l’expérience et malgré de nombreuses tentatives d’explications infructueuses, les physiciens durent admettre la réalité des faits : la vitesse de la lumière est une constante indépendante du référentiel galiléen où elle est mesurée.

L’échec de l’expérience de Michelson et Morley sonna également le glas de l’éther.

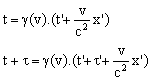

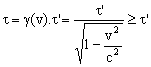

Relativité de l’espace et du temps : contraction des distances et dilatation des durées.

Considérons toujours les deux référentiels galiléens R et R’. La vitesse relative de R’ par rapport à R est v. Prenons une horloge située en x’ dans R’. Le référentiel R’ est celui qui est lié à l’horloge. On l’appelle le référentiel propre à l’horloge. Dans le référentiel propre, considérons deux tops consécutifs de l’horloge survenant en t’ et t' + tau' où t’ est la période des battements de l’horloge. Vu du référentiel R ces instants deviendront :

d’où le battement de l’horloge t dans R vaut :

On remarque que la durée du battement de l’horloge observée dans le référentiel R est supérieure à la durée du battement mesurée dans son référentiel propre. Ce phénomène a été nommé la dilatation des durées. Il est observé tous les jours dans les accélérateurs de particules où les particules atteignent des vitesses très proches de celle de la lumière. La plupart des particules sont instables et se désintègrent au bout de temps très courts. La durée de vie d’une particule est une propriété intrinsèque à chaque particule et n’a de sens physique que dans le référentiel propre de la particule. Ainsi, la durée de vie des particules observée par les physiciens est en revanche très supérieure à leur durée de vie propre.

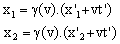

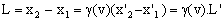

Considérons maintenant une règle de longueur L dans le référentiel R (R constitue donc son référentiel propre) dont les extrémités se trouvent aux abscisses x1 et x2. Dans le référentiel R’, les abscisses des extrémités sont x’1 et x’2. Les relations entre les coordonnées dans R et dans R’ sont :

On en tire que la longueur L de la règle dans R s’exprime en fonction de sa longueur L’ dans R’ de la façon suivante :

d'où :

La longueur de la règle observée dans un référentiel mobile par rapport au référentiel propre de la règle est inférieure à sa longueur propre. Ce phénomène porte le nom de contraction des longueurs.

L’espace de Minkowski

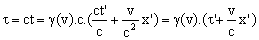

Les transformations de Lorentz, à la différence des transformations galiléennes, ont pour effet de mélanger l’espace et le temps, notamment, et c’est ce qui est nouveau, le temps est lui aussi affecté par la transformation. Si l’on remplace le temps par :

alors les transformations de Lorentz s’écrivent :

On constate que les coordonnées d’espace et le temps (c.t devrions nous plutôt dire) jouent un rôle symétrique dans les transformations de Lorentz. Cette symétrie a conduit Lorentz à considérer le temps comme une dimension d’un espace à quatre dimensions : l’espace-temps.

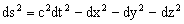

Par ailleurs, Lorentz mit en évidence une propriété essentielle de ce nouvel espace-temps : la grandeur...

...possède la même valeur quel que soit le référentiel galiléen dans lequel on se trouve (il est facile de le vérifier à partir des transformations de Lorentz).

H. Minkowski [21] bâtit à partir des travaux de Lorentz une nouvelle géométrie à quatre dimensions embrassant à la fois les trois dimensions spatiales et le temps. Dans un tel espace, un « point » est repéré par quatre coordonnées (ct, x, y, z), c'est-à-dire par un instant et par une position. Un tel « point » s’appelle un événement. Minkowski définit le ds2 de Lorentz comme la distance spatio-temporelle entre deux événements que nous appelons intervalle spatio-temporel. Il est important de noter que l’intervalle spatio-temporel entre deux événements est une constante indépendante du référentiel galiléen dans lequel on se place. Une grandeur dont la valeur est indépendante du référentiel galiléen est appelée un invariant de Lorentz. On dit aussi que cette grandeur est invariante par transformations de Lorentz.

L’équivalence masse et énergie

L’un des résultats le plus étonnant de la relativité restreinte est la fameuse formule, que l’on doit à Albert Einstein, E = mc2. La démonstration rigoureuse de cette équation ne peut être abordée dans le cadre du programme du 1er cycle universitaire et des classes préparatoires scientifiques. Nous nous contenterons d’en interpréter le sens physique.

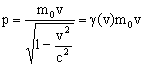

En mécanique relativiste, on montre que la quantité de mouvement d’un corps de masse m0 s’exprime par la formule :

Ce que l’on peut interpréter en disant qu’en relativité restreinte, la quantité de mouvement est égale à sa valeur classique multipliée par le facteur :

Ainsi la quantité de mouvement d’un corps devient-elle infinie pour une vitesse égale à celle de la lumière. Ce phénomène est communément observé dans les accélérateurs de particules dans lesquels les particules atteignent des vitesses très proches de celle de la lumière.

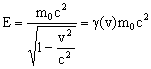

On montre encore que l’énergie totale d’une particule libre de masse m0 suit une loi semblable à celle de la quantité de mouvement :

On constate que pour une vitesse nulle, l’énergie totale du corps est E = m0.c2, ce qui signifie que :

l’énergie d’un corps au repos n’est pas nulle d’une part,

la valeur de « l’énergie de repos » d’un corps est directement proportionnelle à sa masse, d’autre part.

Cette relation n’a aucun équivalent en mécanique classique. En effet, en mécanique classique, une particule libre au repos possède une énergie nulle.

La relation de proportionnalité entre l’énergie au repos d’un corps et sa masse nous apprend que la masse est finalement une forme d’énergie et qu’inversement, l’énergie devrait pouvoir être transformée en masse. Une fois de plus, les réactions entre particules dans les accélérateurs de particules démontrent tous les jours l’équivalence entre masse et énergie. On y observe des particules qui s’annihilent (les masses disparaissent) et se transforment en énergie électromagnétique sous forme de photons. Inversement, deux photons très énergétiques entrant en collision peuvent donner naissance à une paire de particule-antiparticule (création de masse).

Nous conclurons ce paragraphe en constatant que la relativité restreinte a profondément modifié notre conception de grandeurs physiques aussi fondamentales que la masse, l’inertie et l’énergie au point d’en remettre en question la nature même.

La relativité générale

Les limites de la relativité restreinte...

La relativité restreinte ne s’applique qu’aux référentiels galiléens, c'est-à-dire aux référentiels non accélérés. Or dans la nature, toute masse crée un champ gravitationnel dont la portée est infinie. Pour pouvoir trouver un vrai référentiel galiléen il est donc nécessaire de se situer infiniment loin de toute masse. La mécanique relativiste bâtie à partir de la relativité restreinte ne constitue donc qu’une approximation des lois de la nature, dans le cas où les champs gravitationnels ou les accélérations sont suffisamment faibles.

Ce constat ne pouvait satisfaire un esprit comme celui d’Einstein. Comment appliquer le principe de relativité aux référentiels accélérés ? Pour répondre à cette question analysons les différences essentielles qui existent entre un référentiel galiléen et un référentiel accéléré. Pour ce faire, commençons par regarder de plus près le principe d’équivalence.

L’équivalence entre la masse inerte et la masse gravitationnelle : le principe d’équivalence galiléen

Le concept de masse joue un rôle central en mécanique newtonienne. Cependant, tout en étant un concept majeur il n’en demeure pas moins assez mal défini. En effet, la masse intervient implicitement dans les trois lois de Newton comme grandeur liée soit aux phénomènes inertiels (première loi ou principe d’inertie et seconde loi), soit à la gravitation (troisième loi ou loi universelle de la gravitation).

La masse telle que définie dans les deux premières lois de Newton peut être interprétée comme une grandeur mesurant la résistance des corps au mouvement. Plus un corps est massif, plus son inertie est grande c'est-à-dire qu’il est d’autant plus difficile d’en modifier le mouvement. Pour modifier les caractéristiques de son mouvement, il est alors nécessaire de lui appliquer une force qui est proportionnelle, entre autre, à la masse. C’est ce que nous enseigne la loi F = m.a où m est la masse du corps et a son accélération ou, dit autrement, le taux de changement de sa vitesse ou de son mouvement. Nous appellerons la masse interprétée de cette façon, la masse inerte.

Par ailleurs, dans la loi universelle de la gravitation, la masse pourrait plutôt être assimilée à une charge gravitationnelle au même titre que la charge électrique dans la loi de Coulomb. Si l’on remplace dans la loi de Coulomb les charges électriques de deux corps en interaction par leur masse respective, on retrouve la loi de la gravitation, à la constante de proportionnalité et au signe près. Selon cette interprétation, la masse impliquée dans les phénomènes de gravitation se comprend comme une charge gravitationnelle. Nous l’appellerons la masse gravitationnelle.

Il n’existe, a priori, aucune raison physique pour que la masse inerte ait une quelconque relation avec la masse gravitationnelle. Les phénomènes inertiels et gravitationnels sont en effet de nature très différente comme nous l’avons vu précédemment. Pourtant, nous allons montrer que ces deux masses sont étroitement liées l’une à l’autre.

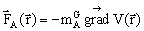

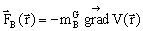

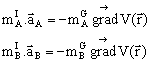

Considérons deux corps A et B de masses inertes mIA et mIB et, de masses gravitationnelles mGA et mGB. Comme nous l’avons déjà fait remarquer, les masses inerte et gravitationnelle de chaque corps n’ont aucune raison d’être égales, c’est pourquoi nous les distinguons volontairement. Supposons ces corps plongés dans un champ gravitationnel dont le potentiel en un point repéré par le vecteur position  est V(

est V( ). La force à laquelle les deux corps sont soumis en un point repéré par

). La force à laquelle les deux corps sont soumis en un point repéré par  est alors :

est alors :

et

Par ailleurs cette force a pour effet d’accélérer les corps, donc de faire varier leur mouvement. Ce phénomène peut être interprété par le moyen de la masse inerte des corps en écrivant :

D’où l’on tire :

Ce que l’on peut encore écrire, en projetant sur l’axe colinéaire au  :

:

Or l’observation montre que deux corps plongés en un même point dans un champ gravitationnel sont soumis à la même accélération. Cette égalité est aujourd’hui vérifiée avec une précision relative qui atteint 10-12 (expériences réalisées dans les années 1960 par Braginsky à Moscou). Donc aA = aB et l’on en déduit :

...et ceci quels que soient les corps A et B.

Cette égalité signifie que le rapport de la masse inerte et de la masse gravitationnelle d’un corps, quel qu’il soit, est une constante universelle. Par un choix astucieux d’unités il est toujours possible de rendre ce rapport égal à l’unité. D’où l’on conclut que les masses gravitationnelle et inerte sont égales. Ce résultat est connu sous le nom de principe d’équivalence galiléen.

Le principe d’équivalence est connu depuis le XIXe siècle mais il fallut attendre Albert Einstein et la théorie de la relativité générale pour qu’il trouve toute sa signification. Le fait tout à fait étonnant et non fortuit que les masses inerte et gravitationnelle soient égales a conduit Einstein à émettre l’hypothèse hardie que la gravitation était, localement, équivalente à une force d’inertie.

Le principe d’équivalence de la relativité générale...

Dans un référentiel accéléré apparaissent des forces d’inertie. Ce sont elles qui projettent les passagers d’une voiture vers l’avant quand celle-ci freine brutalement, ou qui sont responsables de la force centrifuge dans le cas d’un mouvement circulaire.

Supposons que deux fusées, que nous nommerons A et B, se trouvent dans une région de l’espace éloignée de toute masse. Leurs moteurs sont arrêtés ce qui se traduit physiquement par un mouvement rectiligne uniforme. Dans chaque fusée, des physiciens réalisent des expériences de mécanique avec des objets dont ils connaissent la masse inerte. Soudain, le moteur de la fusée A démarre et lui communique une accélération dont l’effet ressenti à l’intérieur du vaisseau spatial est une force d’inertie qui plaque les objets vers le plancher. Pour les physiciens de la fusée A les lois de la mécanique sont alors les mêmes que celles que l’on observe dans un champ gravitationnel. Ils sont donc logiquement amenés à interpréter la force d’inertie comme la manifestation d’un champ gravitationnel. A l’aide d’une balance, ils peuvent alors peser leurs objets et leur attribuer une masse gravitationnelle.

Supposons que les physiciens de la fusée B puissent observer ce qui se passe dans la fusée A. Ils savent que ce que leurs collègues interprètent comme le poids des objets n’est en fait qu’une force d’inertie. La force d’inertie est proportionnelle à l’accélération et à la masse inerte. Si la masse gravitationnelle était différente de la masse inerte les physiciens de la fusée A pourraient distinguer les effets des forces d’inertie de ceux d’un champ de gravitation car les masses mesurées seraient distinctes. Or, nous savons que la masse inerte et la masse gravitationnelle sont équivalentes (principe d’équivalence galiléen). Il s’ensuit que les physiciens de la fusée A n’ont aucun moyen de faire la différence entre des forces d’inertie résultant d’un mouvement accéléré de leur vaisseau spatial et les forces d’attraction gravitationnelles !

Il faut toutefois tempérer les conclusions de cette expérience : les vrais champs de gravitation se distinguent d’un référentiel accéléré dans la mesure où l’accélération gravitationnelle varie avec la distance qui sépare les corps alors que dans un référentiel accéléré, l’accélération est identique en tout point de l’espace. Cependant, localement, un champ gravitationnel et un référentiel accéléré ne peuvent être différenciés.

Albert Einstein appliqua ce résultat à l’ensemble des lois physiques et l’érigea en principe général qu’il baptisa principe d’équivalence. Le principe d’équivalence de la relativité générale peut s’énoncer ainsi :

dans une région « suffisamment petite », les lois physiques sont identiques dans un référentiel accéléré et dans un champ de gravitation.

Le principe de Mach

Si le principe d’équivalence met en évidence l’égalité des masses inerte et gravitationnelle, il ne nous éclaire pas sur la nature de ces deux masses. Finalement, que sont les masses inerte et gravitationnelle ?

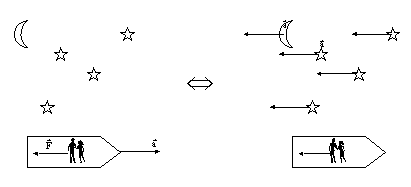

La nature profonde de la masse inerte devrait nous renseigner sur celle de l’inertie elle-même. L’inertie se manifeste sous une forme passive - le principe d’inertie - et une forme active - la seconde loi de Newton. D’une manière générale, elle exprime un comportement universel des corps à résister au changement du mouvement. Or nous savons que le mouvement inertiel est relatif c'est-à-dire qu’il n’existe aucun référentiel absolu. En est-il de même du mouvement accéléré ? Considérons, pour illustrer cette interrogation, une fusée dans laquelle se trouve un physicien et réalisons deux expériences.

Première expérience. La fusée accélère : le physicien est soumis à une force d’inertie orientée dans la direction opposée à celle de l’accélération.

Deuxième expérience. Maintenant supposons que l’on imprime à l’ensemble de l’Univers - à l’exception de la fusée qui se déplace selon un mouvement inertiel - une accélération exactement opposée à celle de la fusée lors de l’expérience précédente.

Si le mouvement accéléré est relatif alors, pour un observateur, il n’est pas possible de distinguer les deux expériences. Notamment, le physicien situé à l’intérieur de la fusée doit observer l’apparition d’une force d’inertie absolument identique à celle qu’il a notée lors de la première expérience. La masse inerte trouverait alors son origine dans les interactions de la masse gravitationnelle des corps avec l’ensemble des masses gravitationnelles de l’Univers ! Selon Ernst Mach [22], un physicien et philosophe du XIXe siècle, le mouvement quel qu’il soit, inertiel ou accéléré, serait relatif.

Cette théorie fut baptisée par Einstein principe de Mach. Jusqu’à ce jour, le principe de Mach n’a pas été confirmé, mais pas davantage infirmé. Il est vrai que sa vérification expérimentale dépasse de beaucoup les capacités humaines !

Tout se passe comme si en déplaçant toutes les masses de l’Univers, celles-ci entraînaient avec elles les objets se trouvant dans la fusée, dont le physicien qui ressent alors une force qui le tire dans le même sens que l’accélération appliquée aux étoiles.

Illustration du principe de Mach. a est l’accélération et F la force d’inertie à l’intérieur de la fusée. Les deux expériences seraient, selon Mach, équivalentes.

Le principe de Mach est devenu un enjeu majeur de la physique contemporaine car il permet d’approfondir notre compréhension des phénomènes gravitationnels et inertiels et constitue un cadre de test ultime de la théorie de la relativité générale. A ce titre, la NASA a développé un projet de sonde gravitationnelle - Gravity Probe B [23] -chargée de mesurer les effets les plus fins de la gravitation terrestre afin de vérifier la validité du principe de Mach.

Gravitation et géométrie

Imaginons maintenant que nos physiciens se trouvent enfermés dans une cage d’ascenseur totalement close. Ils observent aisément les effets du champ gravitationnel sur les phénomènes physiques. Supposons que les câbles de l’ascenseur se rompent subitement et que l’ascenseur tombe en chute libre. N’ayant aucun moyen de s’apercevoir qu’ils tombent, les physiciens à l’intérieur de l’ascenseur penseront qu’ils se trouvent dans un référentiel inertiel ou galiléen (c’est par des moyens similaires que l’on acclimate les astronautes à l’état d’apesanteur). Sur une très courte distance (c'est-à-dire en langage physique localement) l’ascenseur en chute libre peut être assimilé à un référentiel uniformément accéléré (application du principe d’équivalence). Or, le passage du référentiel fixe terrestre au référentiel accéléré de la cage d’ascenseur est réalisé par des transformations de coordonnées. Il en découle que par une « simple » transformation de coordonnées il est possible d’annuler localement un champ gravitationnel ! Faut-il en conclure que la gravitation n’est qu’une affaire de géométrie ?

Einstein intuitivement le pensait. Il supposa que la gravitation n’était que la manifestation de déformations de l’espace-temps. Pour tenter d’illustrer de façon simpliste mais très imagée l’idée d’Einstein, considérons une roue dentée roulant à vitesse constante (disons une dent à la seconde) sur une crémaillère. Imaginons que nous ayons le pouvoir de modifier simultanément le pas de la crémaillère et celui de la roue quand et où nous le désirons. Faisons alors en sorte que le pas de la crémaillère augmente légèrement d’une dent à l’autre. Pour des observateurs fixes la roue est alors animée d’un mouvement uniformément accéléré car, en effet, à chaque tour celle-ci parcourt une distance toujours plus grande. En revanche, si l’on choisit la crémaillère comme référentiel et le pas de celle-ci comme étalon de mesure, le mouvement de la roue est alors uniforme (une dent par seconde). L’accélération de la roue est la conséquence de l’augmentation du pas de la crémaillère.

Poursuivons l’analogie : le pas de la crémaillère joue le rôle d’étalon de mesure local dans notre espace à une dimension que constitue la crémaillère. En géométrie, il porte le nom de métrique. La métrique est ce qui permet de déterminer la distance entre deux points, elle représente en quelque sorte l’étalon infinitésimal d’un espace. En géométrie euclidienne la métrique est une constante ce qui nous permet de créer des étalons de mesure universels. Bernhard Riemann [24], un mathématicien allemand du XIXe siècle, inventa une géométrie où la métrique peut varier d’un point à un autre de l’espace, ce qui lui permit de décrire des espaces courbes comme la surface d’une sphère par exemple.

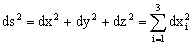

En géométrie euclidienne, la distance entre deux points infiniment voisins s’exprime par :

avec

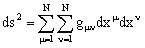

En géométrie de Riemann, cette relation est généralisée comme suit :

(1)

...où N est la dimension de l’espace considéré. A noter que dans les éléments  , m et n jouent le rôle d’indices de sommation et non d’exposants. La matrice qui possède les éléments gmn est un être mathématique nommé tenseur [25]. Ce tenseur a été baptisé le tenseur métrique car il « étalonne » l’espace-temps.

, m et n jouent le rôle d’indices de sommation et non d’exposants. La matrice qui possède les éléments gmn est un être mathématique nommé tenseur [25]. Ce tenseur a été baptisé le tenseur métrique car il « étalonne » l’espace-temps.

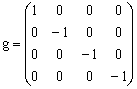

La formulation du ds2 de la relativité restreinte constitue un cas particulier pour lequel le tenseur métrique est la matrice 4x4 suivante :

Ce qui donne bien en appliquant la formule (1) :

En langage mathématique, l’idée d’Einstein se traduit par une métrique dans un espace à quatre dimensions dont les composantes sont variables d’un point de l’espace-temps à un autre. Ces variations de la métrique seraient à l’origine du phénomène de gravitation.

Courbure et gravitation : l’équation d’Einstein

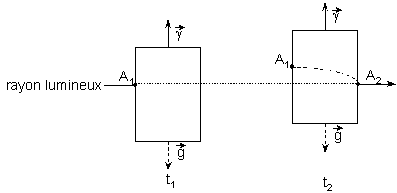

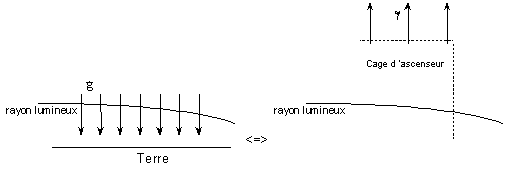

Considérons un ascenseur auquel on imprime une accélération dirigée vers le haut. Pour un observateur situé dans l'ascenseur tout se passe comme s’il se trouvait dans un espace baigné par un champ gravitationnel  dirigé vers le bas (c'est là une illustration directe du principe d'équivalence). Supposons qu'à un instant t1 (voir figure ci-dessous) un rayon lumineux dont la trajectoire est perpendiculaire au mouvement de l'ascenseur entre dans la cage de l'ascenseur en un point A1. Il en ressort à un instant t2 en un point A2. Entre les deux instants, t1 et t2, l'ascenseur s'est déplacé, A2 se trouve donc à une hauteur plus basse que A1. Pour l'observateur situé dans l'ascenseur, tout se passe comme si le rayon lumineux a suivi une trajectoire courbe (parabolique dans le cas présent).

dirigé vers le bas (c'est là une illustration directe du principe d'équivalence). Supposons qu'à un instant t1 (voir figure ci-dessous) un rayon lumineux dont la trajectoire est perpendiculaire au mouvement de l'ascenseur entre dans la cage de l'ascenseur en un point A1. Il en ressort à un instant t2 en un point A2. Entre les deux instants, t1 et t2, l'ascenseur s'est déplacé, A2 se trouve donc à une hauteur plus basse que A1. Pour l'observateur situé dans l'ascenseur, tout se passe comme si le rayon lumineux a suivi une trajectoire courbe (parabolique dans le cas présent).

Expérience de l’ascenseur d’Einstein

Si cette expérience est reproduite alors que l'ascenseur est au repos dans une région de l’espace infiniment éloignée de toute masse, la trajectoire observée par le passager de l’ascenseur est cette fois rectiligne. Pour l’observateur, ces deux expériences se distinguent par la présence d'un champ gravitationnel (en vertu du principe d’équivalence l’accélération à laquelle est soumise l’ascenseur est équivalente à un champ gravitationnel) dans le premier cas, qui est absent dans le second. Il en tire logiquement la conclusion que la présence d'un champ gravitationnel a pour effet de courber la trajectoire des rayons lumineux.

Le champ gravitationnel terrestre est équivalent à un référentiel accéléré. Ce phénomène est imperceptible à la périphérie de la Terre. En revanche, les astronomes ont pu mettre en évidence la courbure de rayons lumineux rasant la surface du Soleil provenant d’étoiles lointaines.

« L’étirement » de l’espace-temps à la périphérie d’une masse peut avoir des conséquences remarquables quand la masse considérée est très grande, comme c’est le cas des étoiles.

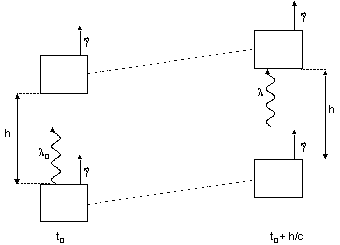

Considérons deux ascenseurs infiniment éloignés de toute matière, distants d’une longueur h (voir figure ci-dessous) et se déplaçant avec une accélération constante  . A l’instant t0 l’ascenseur de queue émet un signal lumineux de longueur d’onde l0. Comme la distance entre les deux ascenseurs reste constante, quand le signal lumineux atteint l’autre ascenseur il s’est écoulé un temps Dt = h/c. Durant ce temps, la vitesse des ascenseurs croît d’une valeur Dv = g.Dt = g.h/c. Il s’ensuit que le signal lumineux subit l’effet Doppler et sa longueur d’onde augmente lorsqu’il arrive à l’ascenseur de tête. La lumière est décalée vers le rouge (phénomène appelé « redshift »).

. A l’instant t0 l’ascenseur de queue émet un signal lumineux de longueur d’onde l0. Comme la distance entre les deux ascenseurs reste constante, quand le signal lumineux atteint l’autre ascenseur il s’est écoulé un temps Dt = h/c. Durant ce temps, la vitesse des ascenseurs croît d’une valeur Dv = g.Dt = g.h/c. Il s’ensuit que le signal lumineux subit l’effet Doppler et sa longueur d’onde augmente lorsqu’il arrive à l’ascenseur de tête. La lumière est décalée vers le rouge (phénomène appelé « redshift »).

Décalage vers le rouge (redshift) gravitationnel

Or, d’après le principe d’équivalence, l’accélération des ascenseurs peut être assimilée à un champ gravitationnel dirigé dans le sens opposé. On en conclut que la lumière s’échappant d’un champ gravitationnel est décalée vers le rouge. Ce décalage est d’autant plus grand que le champ gravitationnel est intense. En 1960, les physiciens Pound et Rebka parvinrent à mettre en évidence et à mesurer avec précision le décalage vers le rouge causé par le champ gravitationnel terrestre. Le résultat était en parfait accord avec les prédictions de la relativité générale.

On peut montrer de la même manière, par une « expérience de pensée » analogue, que « l’étirement » de l’espace-temps affecte toutes les dimensions de l’espace-temps, donc également le temps. La relativité générale prévoit donc que le temps s’écoule plus lentement dans un champ gravitationnel. Ainsi, à l’aide d’horloges atomiques très précises, on a pu mesurer que le temps à la surface de la Terre s’écoule plus lentement qu’à l’intérieur d’un avion volant à haute altitude. Une fois de plus les expériences furent en parfait accord avec la relativité générale.

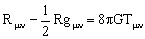

Albert Einstein formula la nouvelle conception de la gravitation dans la célèbre équation qui porte son nom :

...où Rmn est le tenseur de courbure locale de l’espace-temps, R le tenseur de Ricci, gmn le tenseur métrique, G la constante universelle de la gravitation et Tmn le tenseur d’énergie. Au delà des mathématiques très complexes et en mots de tous les jours, cette équation nous apprend que la courbure locale de l’espace-temps (terme de gauche) est proportionnelle à la quantité locale d’énergie et de matière (terme de droite).

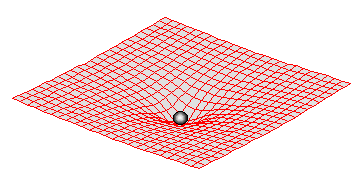

Ainsi, la présence de matière et d’énergie a pour effet de courber l’espace-temps.

Espace-temps à deux dimensions incurvé par la présence d’une masse

(en fait, la masse devrait être représentée comme un objet à deux dimensions elle aussi !).

| 5. Références |

|---|

Quelques références pour aller plus loin :

- ELBAZ E., 1992. « Cosmologie »,Ellipses.

- REEVES H., 1994. « Dernières nouvelles du cosmos, vers la première seconde », Points sciences, Editions du seuil.

- « Naissance et histoire du cosmos », La Recherche (Hors-série n°1, Avril 1998).

- « L’Univers de la gravitation », Science et Vie (Hors-série, n°205, Décembre 1998).

- GOUGUENHEIM L., 1994. « Méthodes de l’astrophysique », Liaisons scientifiques, Hachette CNRS.

- WEINBERG S., 1978. « Les trois premières minutes de l’Univers », Seuil (collection Points sciences).

- LANDAU L., LIFCHITZ E., 1970. « Théorie des champs », Editions Mir.

| 6. Bloc notes |

|---|

[1] Nicolas Copernic, astronome polonais, 1473 - 1543.

[2] Edwin Hubble, astronome américain, 1889 - 1953.

[3] Christian Doppler, mathématicien et physicien autrichien, 1803 - 1853.

[4] Willem de Sitter, astrophysicien hollandais, 1872 - 1934.

[5] Alexandre Friedmann, géophysicien russe, 1888 - 1925.

[6] Georges Lemaître, physicien et prêtre belge, 1894 - 1966.

[7] George Gamow, astrophysicien américain d’origine ukrainienne, 1904 - 1968.

[8] Robert Wilson, radioastronome américain, 1936 -.

[9] Arno Penzias, radioastronome américain, 1933 -.

[10] Explorateur du fond cosmique.

[11] MAP = Microwave Anisotropy Probe (sonde de [mesure de] l’anisotropie [du rayonnement] micro-onde).

[12] Sheldon Lee Glashow, physicien américain, 1932 -.

[13] Abdus Salam, physicien pakistanais, 1926 -.

[14] Steven Weinberg, physicien américain, 1933 -.

[15] Pour reprendre la terminologie introduite dans le chapitre 1 au paragraphe 1.7.2, les gluons sont les quanta de l’interaction forte.

[16] Avec les accélérateurs de particules actuels, des électrons peuvent atteindre des énergies de plus de 100 GeV mais aucun quark à l’état libre n’a encore été observé. En fait, lors du choc de deux électrons à 100 GeV, une multitude de quarks sont créés. L’énergie disponible est transformée en masse et l’énergie restante est insuffisante pour libérer les quarks de l’interaction forte. Les physiciens ont donc pensé accélérer des noyaux atomiques à haute énergie. Les quarks contenus dans les nucléons (c’est ainsi que l’on nomme les protons et les neutrons) devraient alors posséder une énergie suffisante pour que l’on observe un plasma de quarks et de gluons à l’état libre pendant un court instant.

[17] Hendrik Antoon Lorentz, physicien allemand, 1853 - 1928.

[18] En fait, les lois de transformations de Lorentz furent effectivement découvertes par Henri Poincaré en 1905, peu avant la publication de l’article d’Einstein, fondateur de la théorie de la relativité. Poincaré baptisa ces transformations du nom et en l’honneur du célèbre physicien Hendrik Lorentz.

[19] Albert Michelson, physicien américain, 1852 - 1931.

[20] Edward Morley, physicien américain, 1838 - 1923.

[21] Hermann Minkowski, physicien allemand d’origine russe, 1864 - 1909.

[22] Ernst Mach, physicien autrichien, 1838 - 1916.

[23] Gravity Probe B (sonde gravitationnelle B) : projet de satellite terrestre devant transporter un gyroscope très sophistiqué dans le but de mesurer très finement les effets du champ gravitationnel de la Terre. Ce satellite sera lancé dans le courant de l’année 2000 (Pour plus de détails, se reporter au site Internet de la NASA).

[24] Bernhard Riemann, mathématicien allemand, 1826 - 1866.

[25] Un tenseur n’est pas une simple matrice. C’est un objet mathématique qui a pour caractéristique d’être invariant par transformations de Lorentz. On voit que cette propriété, très spécifique, n’est pas remplie par toutes les matrices.